A adoção de IA está avançando rapidamente, passando de projetos piloto para a prática diária no nível da infraestrutura. A curva orçamentária reflete essa mudança. Gartner espera que os gastos mundiais com IA alcancem $2,52 trilhões em 2026, um aumento de 44% ano a ano. Ao mesmo tempo, espera-se que os gastos com segurança cibernética de IA cresçam mais de 90% em 2026, um sinal claro de que, quanto mais a IA é integrada nas operações empresariais, maior se torna a superfície de ataque.

À medida que as organizações operacionalizam LLMs, o verdadeiro desafio passa da qualidade de resposta para a execução segura. Já não é suficiente para um modelo explicar o que fazer. Em muitos ambientes, o valor vem de tomar ações, puxar o contexto correto e interagir com os sistemas onde o trabalho acontece. Isso inclui repositórios de código, plataformas de emissão de tickets, ferramentas SaaS, bancos de dados e serviços internos.

Antes do Protocolo de Contexto de Modelo, cada integração de ferramenta era como construir um cabo personalizado diferente para cada dispositivo, e depois descobrir que cada fornecedor de LLM usava uma tomada ligeiramente diferente. O MCP padroniza o conector e o formato da mensagem; portanto, as ferramentas podem expor recursos uma vez, e vários modelos podem usá-las de forma consistente. O resultado é desenvolvimento mais rápido, menos integrações sob medida e menor manutenção a longo prazo, à medida que a adoção se espalha pelo ecossistema.

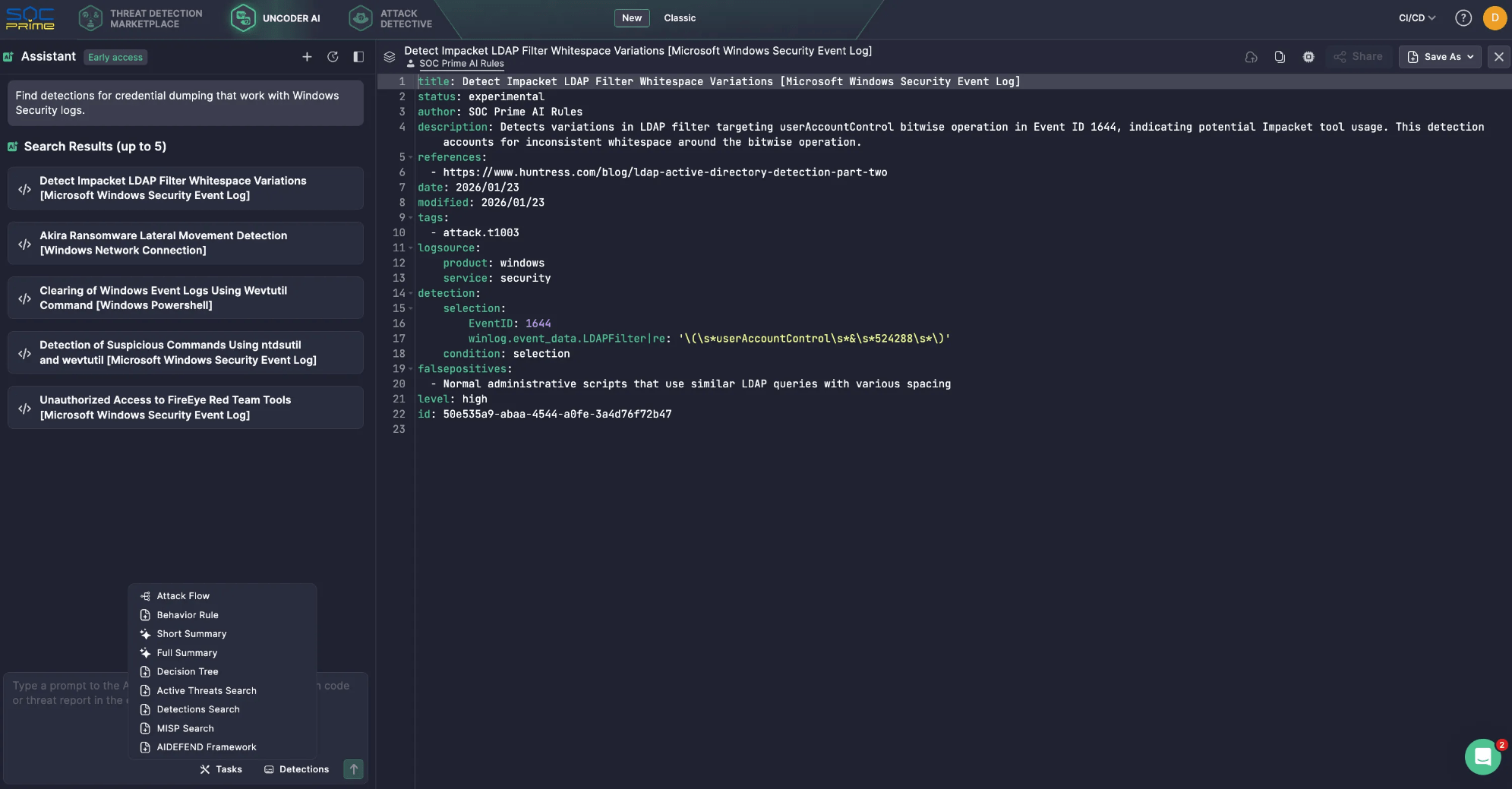

Esta mudança já é visível em assistentes de IA com foco em segurança cibernética. Por exemplo, o Uncoder AI da SOC Prime é impulsionado pelas ferramentas MCP que transformam um LLM em um co-piloto de segurança cibernética ciente do contexto, suportando integração mais fácil, flexibilidade de fornecedores, conexões pré-construídas e manipulação de dados mais controlada. Por exemplo, o MCP permite pesquisas semânticas no Threat Detection Marketplace, encontrando rapidamente regras para fontes de log ou tipos de ameaças específicas, reduzindo o tempo de busca manual. Tudo isso é apoiado por privacidade e segurança em seu núcleo.

Ainda assim, em geral, quando o MCP se torna um caminho comum entre agentes e sistemas críticos, cada servidor, conector e escopo de permissão se torna relevante para a segurança. Tokens amplos demais, isolamento fraco e trilhas de auditoria incompletas podem transformar conveniência em exposição de dados, ações não intencionais ou movimento lateral.

Este guia explica como o MCP funciona, e depois se concentra em riscos de segurança práticos e mitigações.

O que é MCP?

Desde que foi lançado e disponibilizado como código aberto pela Anthropic em novembro de 2024, o Protocolo de Contexto de Modelo ganhou rapidamente tração como a camada de conexão entre agentes de IA e as ferramentas, APIs e dados de que eles dependem.

Em sua essência, o MCP é uma forma padronizada para que as aplicações alimentadas por LLM se comuniquem com sistemas externos de maneira consistente e controlada. Ele move assistentes de IA além do conhecimento estático do tempo de treinamento, permitindo que eles recuperem contexto atualizado e realizem ações através de interfaces aprovadas. O resultado prático é um agente de IA que pode ser mais preciso e útil, porque pode trabalhar com dados operacionais reais.

Componentes Principais

Protocolo de Contexto de Modelo a arquitetura é construída em torno de um conjunto simples de blocos que coordenam como um LLM descobre capacidades externas, puxa o contexto correto e troca solicitações e respostas estruturadas com sistemas conectados.

- Host MCP. O ambiente onde o LLM é executado. Exemplos incluem um IDE com IA embutida ou uma interface de conversa embutida em um produto. O host gerencia a sessão do usuário e decide quando contexto ou ações externas são necessárias.

- Cliente MCP. Um componente dentro do host que lida com a comunicação do protocolo. Descobre servidores MCP, solicita metadados sobre capacidades disponíveis e traduz a intenção do modelo em solicitações estruturadas. Também retorna respostas de volta ao host em uma forma que a aplicação pode usar.

-

Servidor MCP. O serviço externo que fornece contexto e capacidades. Ele pode acessar fontes de dados internas, plataformas SaaS, ferramentas de segurança especializadas ou fluxos de trabalho proprietários. Este é o local onde as organizações geralmente aplicam autorização específica do sistema, filtragem de dados e trilhos de segurança operacionais.

Camadas

- Camada de dados. Esta camada interna é baseada no protocolo JSON-RPC e lida com a comunicação cliente-servidor. Cobre o gerenciamento do ciclo de vida e os primitivos centrais que MCP expõe, incluindo ferramentas, recursos, prompts e notificações.

-

Camada de transporte. Esta camada externa define como as mensagens realmente se movem entre clientes e servidores. Especifica os mecanismos e canais de comunicação, incluindo configuração de conexão específica de transporte, formatação de mensagens e autorização.

Conceitualmente, a camada de dados fornece o contrato e a semântica, enquanto a camada de transporte fornece a conectividade e o caminho de aplicação para troca segura.

Como o MCP funciona?

O MCP fica entre o LLM e os sistemas externos que seu agente planeja usar. Em vez de dar ao modelo acesso direto a bancos de dados, aplicativos SaaS ou serviços internos, o MCP expõe capacidades aprovadas como ferramentas e fornece uma maneira padrão de chamá-los. O LLM se concentra em entender a solicitação e decidir o que fazer em seguida. O MCP lida com a descoberta de ferramentas, execução e retorno de resultados em um formato previsível.

Um fluxo típico pode parecer com o seguinte:

- O usuário faz uma pergunta ou dá uma tarefa. O prompt chega na aplicação de IA, também chamada de host do MCP.

- Descoberta de ferramentas. O cliente MCP verifica um ou mais servidores MCP para ver quais ferramentas estão disponíveis para esta sessão.

- Injeção de contexto. O MCP adiciona detalhes relevantes da ferramenta ao prompt, para que o LLM saiba o que pode usar e como chamá-lo.

- Geração de chamada de ferramenta. O LLM cria uma solicitação de ferramenta estruturada, basicamente uma chamada de função com parâmetros.

- Execução no serviço downstream. O servidor MCP recebe a solicitação e a executa contra o sistema alvo, muitas vezes através de uma API como REST.

-

Resultados são retornados e usados. A saída volta para a aplicação de IA. O LLM pode usá-la para fazer outra chamada ou para escrever a resposta final.

Aqui está um exemplo simples de como isso funciona no Uncoder AI. Você pergunta: “Encontre detecções para despejo de credenciais que funcionem com logs de segurança do Windows.”

- O LLM percebe que precisa acessar uma biblioteca de detecção, não apenas seu próprio conhecimento.

- Através do MCP, o Uncoder AI chama a ferramenta de Busca de Detecção relevante conectada ao Marketplace de Detecção de Ameaças da SOC Prime.

- O servidor MCP executa a busca e retorna uma lista curta de detecções correspondentes.

- O Uncoder AI então revisa os resultados e responde com uma lista limpa de cinco regras de detecção.

Riscos e Vulnerabilidades do MCP

O Protocolo de Contexto de Modelo expande o que um LLM pode fazer conectando-o a ferramentas, APIs e dados operacionais. Essa capacidade é o valor, mas também é o risco. Uma vez que um assistente pode recuperar contexto interno e acionar ações através de serviços conectados, o MCP se torna parte do seu plano de controle. A postura de segurança não é mais definida apenas pelo modelo, mas pelos servidores em que você confia, as permissões que você concede e os trilhos de segurança que você aplica em torno do uso de ferramentas.

Considerações-chave de segurança do MCP

Os servidores MCP servem como a cola entre os hosts e uma ampla gama de sistemas externos, incluindo potencialmente não confiáveis ou arriscados. Compreender sua exposição requer visibilidade sobre o que está em cada lado do limite do servidor, quais hosts e clientes de LLM estão chamando ele, como o servidor está configurado, quais servidores de terceiros estão habilitados e quais ferramentas o modelo pode realmente invocar na prática.

- Problema do Delegado Confuso. Se um servidor MCP puder agir com privilégios mais amplos do que o usuário, ele pode executar ações que o usuário não deveria ter permissão para acionar. O padrão seguro é que o servidor aja em nome do usuário com consentimento explícito e escopos de menor privilégio, não com uma identidade de serviço ampla.

- Passagem de Token. Passar tokens de cliente para APIs downstream sem validação adequada quebra limites de confiança e pode derrotar controles de audiência. A orientação do MCP trata isso como um padrão de alto risco porque torna a autorização ambígua e difícil de auditar.

- Sequestro de Sessão e Injeção de Evento. Conexões com estado podem ser abusadas se identificadores de sessão puderem ser roubados, repetidos ou retomados por um invasor. O manuseio seguro da sessão é importante porque chamadas de ferramentas se tornam uma sequência, não uma solicitação única, e os invasores visam o elo mais fraco nessa cadeia.

- Comprometimento do Servidor MCP Local. Servidores locais podem ser poderosos, e esse poder corta dos dois lados. Os riscos incluem execução de código não confiável, comportamento inseguro de inicialização e exposição de um serviço local de uma forma que outro site ou processo possa alcançá-lo. Desdobramentos locais precisam de sandboxing, ligação restrita e padrões seguros.

-

Falhas de Minimização de Escopo. Escopos excessivamente amplos aumentam o raio de explosão e enfraquecem a governança. As especificações destacam as armadilhas de design de escopo, como sobrecarregar um único escopo para muitas operações ou anunciar suporte excessivo de escopo. Escopos de menor privilégio e separação clara de capacidades de leitura e escrita são essenciais.

Muitos riscos do MCP mapeiam para fundamentos de segurança familiares; portanto, os servidores MCP devem ser tratados como qualquer outra superfície de integração. As organizações precisam aplicar controles de cadeia de suprimentos, escanear código e dependências, fixar versões e revisar mudanças antes do lançamento. Além disso, é importante reforçar endpoints com autenticação e autorização fortes, limites de taxa e padrões seguros. Essas práticas eliminam uma grande parcela de falhas evitáveis.

A especificação do MCP fornece uma lista de melhores práticas de segurança, com padrões de ataque comuns e mitigações práticas que você pode aplicar ao construir ou operar hosts, clientes e servidores MCP.

Principais Riscos de Segurança do MCP

Para tornar a lista acionável, ajuda agrupar as ameaças do MCP nos padrões de risco mais comuns que os defensores veem em implantações reais.

Injeção de Prompt

Atacantes criam entradas que empurram o assistente para uso não seguro de ferramentas ou divulgação de dados sensíveis.

Dica de mitigação: Restringir acesso a ferramentas, aplicar políticas de chamada e monitorar o uso de ferramentas para padrões anormais.

Injeção Indireta de Prompt

Instruções hostis podem chegar através de conteúdo recuperado e ser tratadas como intenção confiável.

Dica de mitigação: Segregar conteúdo não confiável, sanitizá-lo e evitar que ferramentas sejam invocadas com base em instruções encontradas em dados externos.

Envenenamento de Ferramentas

Descrição, parâmetros ou padrões de ferramentas podem ser manipulados para direcionar decisões do modelo.

Dica de mitigação: Tratar metadados de ferramentas como entrada não confiável, revisar definições de ferramentas como código e exigir verificações de integridade antes das atualizações.

Sombreamento de Ferramentas e Colisão de Nome de Ferramenta

Ferramentas semelhantes podem se passar por legítimas e capturar solicitações.

Dica de mitigação: Manter uma lista de aprovação de servidores e ferramentas, e falhar de forma fechada quando uma identidade de ferramenta não puder ser verificada.

Falhas de Autorização de Delegado Confuso

Um servidor executa ações usando seus próprios privilégios amplos em vez de permissões vinculadas ao usuário.

Dica de mitigação: Usar consentimento explícito, aplicar escopos vinculados ao usuário e validar tokens conforme exigido pela orientação de autorização do MCP.

Passagem de Token e Validação Fraca de Token

Encaminhar tokens ou aceitar tokens sem validação adequada da audiência compromete a autorização.

Dica de mitigação: Proibir passagem, validar audiência de token e seguir o fluxo baseado em OAuth definido para transportes HTTP.

Sequestro de Sessão

Atacantes abusam de sessões retomáveis ou identificadores roubados para injetar eventos ou se passar por um cliente.

Dica de mitigação: Vincular sessões de forma rígida, rotacionar identificadores, aplicar limites de tempo e registrar retomadas e anomalias.

Comprometimento de Servidor Local

Servidores MCP locais podem ser aproveitados para acessar arquivos, executar comandos ou mover-se para outros recursos se não forem isolados.

Dica de mitigação: Isolar servidores locais em sandbox, minimizar privilégios do sistema operacional, restringir acesso ao sistema de arquivos e evitar expor serviços locais além do necessário.

Escopos Excessivos e Proliferação de Permissões

Escopos amplos criam acesso não intencional, e permissões tendem a se acumular com o tempo.

Dica de mitigação: Dividir ferramentas de leitura e escrita, revisar escopos regularmente e manter conjuntos de escopos mínimos e específicos para tarefas.

Falta de Auditabilidade e Resposta Incidente Fraca

Se você não puder correlacionar prompts, chamadas de ferramentas, tokens e ações downstream, investigações se tornam um palpite.

Dica de mitigação: Centralizar logs, anexar IDs de correlação e registrar intenção de chamadas de ferramentas, parâmetros e resultados em um formato amigável ao SIEM.

A conclusão prática é que o MCP deve ser protegido como uma camada de integração de alto impacto. Assuma que as saídas de ferramentas não são confiáveis, minimize permissões, aplique identidade e autorização fortes, e invista cedo em monitoramento que possa vincular prompts a chamadas de ferramentas e ações downstream.

A SOC Prime segue práticas de segurança e privacidade estabelecidas para proteger clientes e garantir a operação confiável da Plataforma SOC Prime e das capacidades habilitadas pela IA. A equipe da SOC Prime também criou e disponibilizou como código aberto o AI/DR Bastion, um sistema abrangente de proteção GenAI projetado para proteger contra prompts maliciosos, ataques de injeção e conteúdo prejudicial. O sistema incorpora múltiplos mecanismos de detecção que operam sequencialmente para analisar e classificar entradas de usuários antes que alcancem aplicativos GenAI.

Além disso, a Plataforma SOC Prime suporta integração com o AIDEFEND (Framework de Defesa de Inteligência Artificial), uma base de conhecimento aberta e focada em IA de medidas defensivas para ameaças emergentes de IA/ML. Apoiado por Uncoder AI, o MCP nativo no AIDEFEND torna este conhecimento imediatamente acionável. Os profissionais de segurança podem solicitar defesas contra ameaças específicas, obter orientações detalhadas de técnicas, gerar listas de verificação rápidas ou extrair trechos de código seguro para implementar controles mais rapidamente e com menos sobrecarga de pesquisa.

Qual é o futuro da segurança do MCP?

As preocupações com a segurança em torno do MCP são válidas, mas a padronização também é uma grande oportunidade para melhorar o controle. À medida que a adoção do MCP cresce, as organizações obtêm uma superfície de segurança mais consistente onde podem aplicar as mesmas políticas e monitoramento em todo o uso de ferramentas, em vez de assegurar uma integração personalizada diferente para cada modelo e cada sistema downstream.

Olhando para o futuro, a segurança do MCP amadurecerá em algumas direções previsíveis:

- Proteger os blocos de construção do MCP. A segurança do MCP se concentrará cada vez mais nos primitivos do protocolo que definem o que um agente pode fazer. Ferramentas são funções executáveis e precisam de permissões rígidas e regras claras para quando podem ser executadas. Recursos atuam como contêineres de dados e precisam de controle de acesso e validação para reduzir vazamento e envenenamento. Prompts influenciam o comportamento e devem ser protegidos com soluções, como AI/DR Bastion, contra injeção e modificação não autorizada.

- Tornar a identidade obrigatória para o MCP remoto. Para qualquer servidor MCP em rede, a autenticação deve ser tratada como um requisito básico. As equipes precisam de um modelo de identidade claro que responda quem está fazendo a chamada, o que eles têm permissão para fazer e qual consentimento foi concedido. Isso também ajuda a prevenir falhas comuns destacadas na especificação, como comportamento de delegado confuso e padrões arriscados de manuseio de token.

- Aplicar política usando contexto completo. Listas de permissão são úteis, mas os fluxos de trabalho de agentes precisam de trilhos de segurança mais ricos. O prompt, o usuário, a ferramenta selecionada, os parâmetros da ferramenta e o sistema alvo devem todos influenciar o que é permitido. Com esse contexto, você pode restringir operações arriscadas, limitar a recuperação de dados sensíveis, bloquear padrões de parâmetros inseguros e exigir verificações extras quando o nível de risco for alto.

- Tratar as medidas de monitoramento como controle central. À medida que agentes encadeiam ações, a investigação depende de poder rastrear o comportamento de ponta a ponta. Um padrão básico prático é o registro que correlaciona prompts, seleção de ferramentas, entradas de ferramentas, saídas de ferramentas e solicitações downstream. Sem essa ligação, é difícil auditar ações ou responder rapidamente quando algo dá errado.

- Adicionar portões de aprovação para ações de alto impacto. Para ações que criam, modificam, deletam, pagam ou escalam privilégios, a revisão humana continua essencial. Implantações maduras do MCP adicionarão etapas de aprovação explícitas que pausarão a execução até que um usuário ou um fluxo de trabalho de segurança confirme a ação. Isso reduz a superfície de ataque tanto de prompts maliciosos quanto de uso indevido acidental de ferramentas.

- Verificar servidores e controlar atualizações. À medida que o ecossistema se expande, confiança e proveniência se tornam obrigatórias. As organizações dependerão cada vez mais de servidores MCP aprovados, integração controlada e gestão de mudanças rigorosa para atualizações. Fixação de versões, verificações de integridade e varredura de dependências são importantes porque os servidores MCP são código executável, e o comportamento das ferramentas pode mudar com o tempo, mesmo que as interfaces pareçam estáveis.

-

Manter os fundamentos em primeiro plano. Mesmo com controles específicos do MCP, as práticas de segurança mais comuns permanecem as básicas. Menor privilégio, escopos claros, manuseio seguro de sessão, autenticação forte, endpoints reforçados e registro completo de auditoria removem uma grande parte do risco no mundo real. Use a lista de melhores práticas de segurança do MCP como uma lista de verificação permanente, depois adicione controles com base no seu ambiente e apetite por risco.

À medida que o MCP se espalha por mais assistentes e ferramentas, a segurança se torna a diferença entre um co-piloto útil e um motor de automação não controlado. O caminho mais seguro é simples: tratar o MCP como infraestrutura privilegiada, manter as permissões rígidas e tornar cada chamada de ferramenta visível e rastreável. Faça isso bem, e o MCP pode escalonar fluxos de trabalho de agentes com confiança, em vez de transformar velocidade em risco.

FAQ

O que são servidores MCP?

O servidor MCP é um bloco de construção na arquitetura do MCP ao lado do host MCP e do cliente MCP. Os servidores MCP concedem capacidades aprovadas a um assistente de IA ao expor ferramentas e recursos que o LLM pode usar. Os servidores MCP fornecem contexto, dados ou ações ao LLM e intermedeiam acesso a sistemas downstream, como aplicativos SaaS, bancos de dados, serviços internos ou ferramentas de segurança. Em outras palavras, um servidor MCP é o portão controlado onde as organizações podem aplicar autorização, filtragem de dados e trilhos de segurança operacionais antes que qualquer coisa toque nos sistemas de produção.

Como os servidores MCP funcionam?

Os servidores MCP ficam atrás do cliente MCP dentro de uma aplicação de IA. Quando um usuário envia uma solicitação, o cliente MCP descobre quais ferramentas estão disponíveis em um ou mais servidores MCP e passa o contexto relevante da ferramenta para o LLM. O LLM então decide o que fazer e gera uma chamada de ferramenta estruturada com parâmetros. O cliente MCP envia essa chamada de ferramenta para o servidor MCP, que a executa contra o sistema downstream e retorna o resultado em um formato previsível. O cliente alimenta o resultado de volta para o LLM, que faz outra chamada de ferramenta ou produz a resposta final para o usuário.

O que é fluxo de segurança do MCP?

O fluxo de segurança do MCP é o conjunto de controles, melhores práticas e passos arquiteturais necessários para implementar com segurança o Protocolo de Contexto de Modelo. Ele começa com identidade forte, consentimento e escopos de menor privilégio para que o servidor MCP aja em nome do usuário em vez de usar permissões de serviço amplas. Inclui manuseio seguro de token e proteções de sessão para reduzir o risco de passagem de token, sequestro de sessão ou injeção de evento. Por fim, depende de aplicação e visibilidade, incluindo listas de permissão de ferramentas, validação de entrada e saída, isolamento para servidores locais e registro centralizado que vincula prompts a chamadas de ferramentas e ações downstream para investigação e resposta a incidentes.