Die Einführung von KI schreitet schnell voran, von Pilotprojekten zur infrastrukturellen Alltagspraxis. Die Budgetkurve spiegelt diesen Wandel wider. Gartner erwartet, dass die weltweiten KI-Ausgaben bis 2026 2,52 Billionen USD erreichen werden, was einem Anstieg von 44 % gegenüber dem Vorjahr entspricht. Gleichzeitig sollen die Ausgaben für KI-Sicherheit bis 2026 um mehr als 90 % wachsen, ein klares Signal dafür, dass je tiefer KI in Geschäftsabläufe eingebettet wird, desto größer wird die Angriffsfläche.

Während Organisationen LLMs operationalisieren, verlagert sich die eigentliche Herausforderung von der Reaktionsqualität zur sicheren Ausführung. Es reicht nicht mehr, wenn ein Modell erklärt, was zu tun ist. In vielen Umgebungen besteht der Wert darin, Maßnahmen zu ergreifen, den richtigen Kontext zu ziehen und mit den Systemen zu interagieren, in denen die Arbeit stattfindet. Dazu gehören Code-Repositories, Ticketing-Plattformen, SaaS-Tools, Datenbanken und interne Dienste.

Vor dem Model Context Protocol glich jede Tool-Integration dem Bau eines individuellen Spezialkabels für jedes Gerät, um dann festzustellen, dass jeder LLM-Anbieter einen leicht unterschiedlichen Stecker verwendete. MCP standardisiert den Anschluss und das Nachrichtenformat, sodass Werkzeuge einmal ihre Fähigkeiten offenlegen können, und mehrere Modelle können sie konsistent nutzen. Das Ergebnis ist eine schnellere Entwicklung, weniger maßgeschneiderte Integrationen und geringere langfristige Wartungen, da die Einführung im gesamten Ökosystem zunimmt.

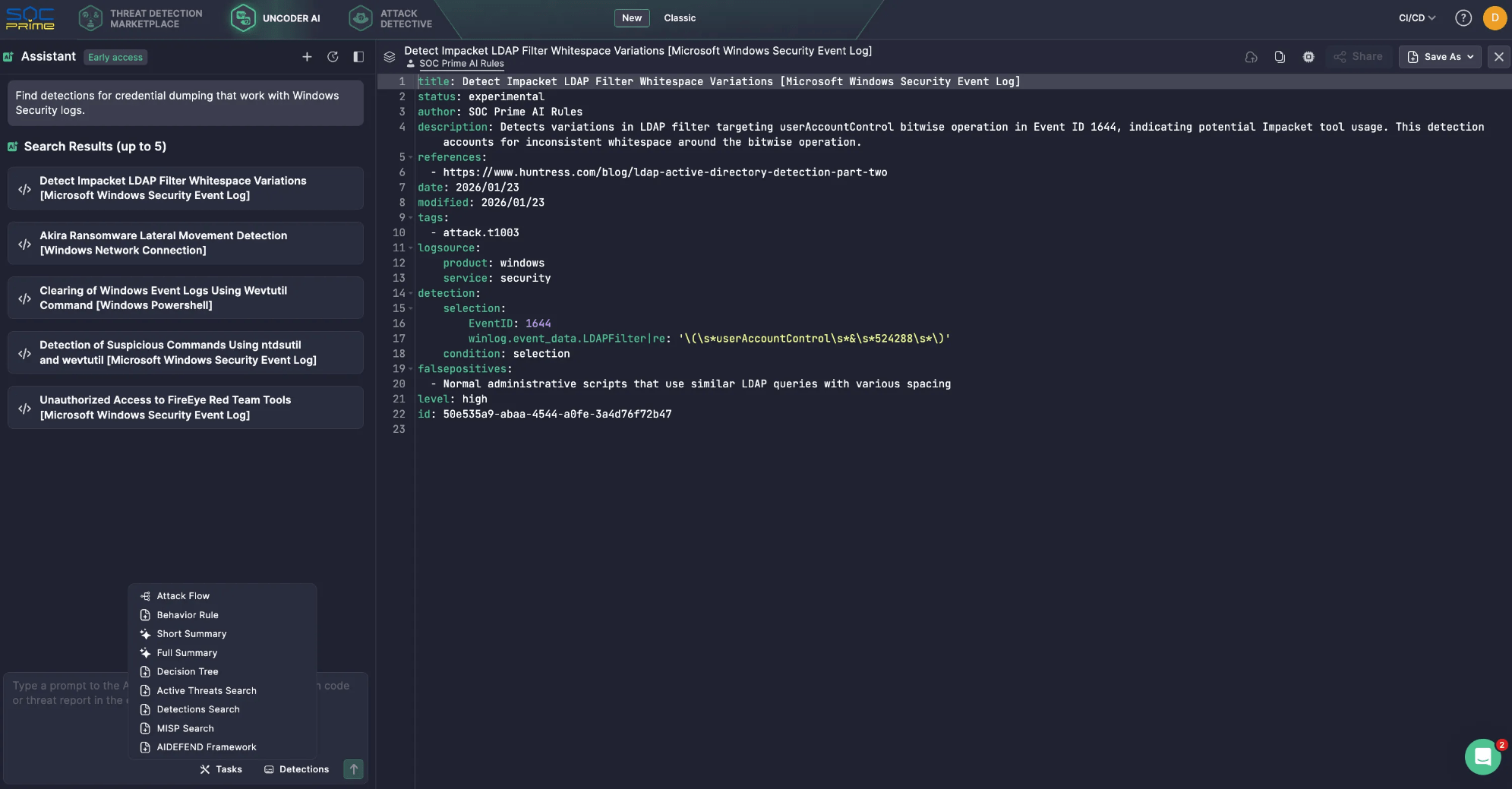

Diese Verschiebung ist bereits bei AI-Assistenten mit Sicherheitsfokus sichtbar. Zum Beispiel, SOC Primes Uncoder AI wird betrieben durch MCP-Werkzeuge die ein LLM in einen kontextbewussten Sicherheitskopiloten verwandeln, der eine leichtere Integration, Anbieterflexibilität, vorgefertigte Verbindungen und eine kontrolliertere Datenhandhabung unterstützt. Beispielsweise ermöglicht MCP semantische Suchen im Threat Detection Marketplace, sodass schnell Regeln für spezifische Logquellen oder Bedrohungstypen gefunden werden können, wodurch die manuelle Suchzeit reduziert wird. All dies wird durch Datenschutz und Sicherheit im Kern unterstützt.

Im Allgemeinen wird jedoch, wenn MCP zu einem gemeinsamen Pfad zwischen Agenten und kritischen Systemen wird, jeder Server, jeder Verbinder und jeder Berechtigungsbereich sicherheitsrelevant. Zuviel weitreichende Tokens, schwache Isolation und unvollständige Prüfpfade können Bequemlichkeit in Datenexponierung, unbeabsichtigte Aktionen oder seitliche Bewegungen verwandeln.

Dieser Leitfaden erklärt, wie MCP funktioniert, und konzentriert sich dann auf praktische Sicherheitsrisiken und -minderungen.

Was ist MCP?

Seit es von Anthropic veröffentlicht und als Open Source bereitgestellt wurde im November 2024, hat das Model Context Protocol schnell an Bedeutung als Verbindungsschicht zwischen KI-Agenten und den Tools, APIs und Daten, auf die sie angewiesen sind, gewonnen.

Im Kern ist MCP eine standardisierte Methode für von LLM betriebene Anwendungen, um auf konsistente und kontrollierte Weise mit externen Systemen zu kommunizieren. Es bewegt KI-Assistenten über statisches Wissen aus der Trainingszeit hinaus, indem es ihnen ermöglicht, frischen Kontext abzurufen und Aktionen über genehmigte Schnittstellen auszuführen. Das praktische Ergebnis ist ein KI-Agent, der genauer und nützlicher sein kann, weil er mit echten Betriebsdaten arbeiten kann.

Schlüsselkomponenten

Model Context Protocol Architektur basiert auf einem einfachen Satz von Blöcken, die koordinieren, wie ein LLM externe Fähigkeiten entdeckt, den richtigen Kontext abruft und strukturierte Anfragen und Antworten mit verbundenen Systemen austauscht.

- MCP-Host. Die Umgebung, in der das LLM läuft. Beispiele umfassen eine KI-gesteuerte IDE oder eine in ein Produkt eingebettete Konversationsoberfläche. Der Host verwaltet die Benutzersitzung und entscheidet, wann externer Kontext oder Aktionen benötigt werden.

- MCP-Client. Eine Komponente im Inneren des Hosts, die die Protokollkommunikation handhabt. Es entdeckt MCP-Server, fordert Metadaten über verfügbare Fähigkeiten an und übersetzt die Absicht des Modells in strukturierte Anfragen. Es liefert auch Antworten in einer für die Anwendung verwertbaren Form an den Host zurück.

-

MCP-Server. Der externe Dienst, der Kontext und Fähigkeiten bereitstellt. Er kann auf interne Datenquellen, SaaS-Plattformen, spezialisierte Sicherheitstools oder proprietäre Arbeitsabläufe zugreifen. Hier setzen Organisationen typischerweise systembezogene Autorisierungen durch, filtern Daten und legen betriebliche Leitplanken fest.

Schichten

- Datenebene. Diese innere Ebene basiert auf dem JSON-RPC-Protokoll und kümmert sich um die Client-Server-Kommunikation. Sie deckt das Lebenszyklusmanagement und die grundlegenden Primitive ab, die MCP bereitstellt, einschließlich Werkzeuge, Ressourcen, Aufforderungen und Benachrichtigungen.

-

Transportschicht. Diese äußere Schicht definiert, wie Nachrichten tatsächlich zwischen Clients und Servern bewegt werden. Sie bestimmt die Kommunikationsmechanismen und Kanäle, einschließlich transport-spezifischer Verbindungsaufbau, Nachrichtenrahmen und Autorisierung.

Konzeptionell bietet die Datenebene den Vertrag und die Semantik, während die Transportschicht den Konnektivitäts- und Durchsetzungspfad für den sicheren Austausch bietet.

Wie funktioniert das MCP?

MCP sitzt zwischen dem LLM und den externen Systemen, die Ihr Agent verwenden möchte. Anstatt dem Modell direkten Zugriff auf Datenbanken, SaaS-Anwendungen oder interne Dienste zu geben, offenbart MCP genehmigte Fähigkeiten als Werkzeuge und bietet eine standardisierte Möglichkeit, diese aufzurufen. Das LLM konzentriert sich darauf, die Anfrage zu verstehen und zu entscheiden, was als Nächstes zu tun ist. MCP kümmert sich um die Werksentdeckung, Ausführung und Rückgabe von Ergebnissen in einem vorhersehbaren Format.

Ein typischer Ablauf kann wie folgt aussehen:

- Der Benutzer stellt eine Frage oder gibt eine Aufgabe. Der Prompt kommt in der KI-Anwendung an, auch MCP-Host genannt.

- Werkzeugentdeckung. Der MCP-Client überprüft einen oder mehrere MCP-Server, um zu sehen, welche Werkzeuge für diese Sitzung verfügbar sind.

- Kontextinjektion. MCP fügt dem Prompt relevante Werkzeugdetails hinzu, sodass das LLM weiß, was es benutzen kann und wie es aufzurufen ist.

- Werkzeugaufruf-Generierung. Das LLM erstellt eine strukturierte Werkzeuganfrage, im Grunde ein Funktionsaufruf mit Parametern.

- Ausführung im Downstream-Dienst. Der MCP-Server erhält die Anfrage und führt sie gegen das Zielsystem aus, oft über eine API wie REST.

-

Ergebnisse werden zurückgegeben und verwendet. Das Ergebnis kommt zur KI-Anwendung zurück. Das LLM kann es nutzen, um einen weiteren Aufruf zu tätigen oder die endgültige Antwort zu schreiben.

Hier ist ein einfaches Beispiel, wie das bei Uncoder AIfunktioniert. Sie fragen: „Finde Erkennungen für Credential Dumping, die mit Windows-Sicherheitslogs arbeiten.”

- Das LLM stellt fest, dass es Zugriff auf eine Erkennungsbibliothek benötigt, nicht nur auf sein eigenes Wissen.

- Über MCP ruft Uncoder AI das relevante Erkennungssuchwerkzeug auf, das mit SOC Primes Threat Detection Marketplace verbunden ist.

- Der MCP-Server führt die Suche durch und liefert eine kurze Liste passender Erkennungen.

- Anschließend überprüft Uncoder AI die Ergebnisse und antwortet mit einer übersichtlichen Liste von fünf Erkennungsregeln.

MCP-Risiken & Schwachstellen

Das Model Context Protocol erweitert, was ein LLM tun kann, indem es es mit Werkzeugen, APIs und betriebsrelevanten Daten verbindet. Diese Fähigkeit ist der Wert, aber auch das Risiko. Sobald ein Assistent internen Kontext abrufen und Aktionen über verbundene Dienste auslösen kann, wird MCP Teil Ihrer Steuerungsebene. Die Sicherheitslage wird nicht mehr allein durch das Modell bestimmt, sondern durch die Server, denen Sie vertrauen, die Berechtigungen, die Sie erteilen, und die Leitplanken, die Sie um die Nutzung der Werkzeuge legen.

Wichtige MCP-Sicherheitsüberlegungen

MCP-Server fungieren als das Bindeglied zwischen Hosts und einer breiten Palette externer Systeme, einschließlich potenziell unzuverlässiger oder riskanter. Ihr Eintritt erfordert Sichtbarkeit darüber, was sich auf jeder Seite der Servergrenze befindet, welche LLM-Hosts und -Clients darauf zugreifen, wie der Server konfiguriert ist, welche Drittanbieter-Server aktiviert sind und welche Werkzeuge das Modell tatsächlich aufrufen kann.

- Problem des verwirrten Stellvertreters. Wenn ein MCP-Server mit umfassenderen Berechtigungen als der Benutzer handeln kann, kann er Aktionen ausführen, die der Benutzer nicht auslösen sollte. Das sichere Muster ist, dass der Server im Namen des Benutzers mit ausdrücklicher Zustimmung und im Rahmen von Minimalberechtigungen handelt, nicht mit einer pauschalen Dienstidentität.

- Token-Durchleitung. Das Durchleiten von Client-Tokens an Downstream-APIs ohne geeignete Validierung bricht die Vertrauensgrenzen und kann die Einhaltung der Adressierungskontrollen untergraben. Die MCP-Leitlinien betrachten dies als hochriskantes Antimuster, weil es die Autorisierung unklar und schwer auditierbar macht.

- Sitzungshijacking und Ereignisinjektion. Zustandsbehaftete Verbindungen können missbraucht werden, wenn Sitzungskennungen gestohlen, wiederholt oder von einem Angreifer fortgesetzt werden können. Sichere Sitzungsverwaltung ist wichtig, da Werkzeugaufrufe eine Abfolge, nicht nur eine einzelne Anfrage, werden, und Angreifer das schwächste Glied in dieser Kette ins Visier nehmen.

- Kompromittierung des lokalen MCP-Servers. Lokale Server können mächtig sein, und diese Macht wirkt in beide Richtungen. Risiken umfassen unerwünschten Code zu betreiben, unsicheres Startverhalten und die Bereitstellung eines lokalen Dienstes auf eine Weise, dass eine andere Website oder Prozess darauf zugreifen kann. Lokale Bereitstellungen erfordern Sandboxing, strikte Bindung und sichere Standardwerte.

-

Fehler bei der Reduktion des Umfangs. Zu breit gefasste Geltungsbereiche erhöhen den Schadenradius und schwächen die Governance. Die Spezifikationen heben Designfallen bei der Umfangdefinition hervor, wie die Überladung eines einzelnen Umfangs für viele Operationen oder das Anbieten überzogenen Umfangsunterstützung. Minimalberechtigungsumfänge und klare Trennungen von Lese- und Schreibfähigkeiten sind unerlässlich.

Viele MCP-Risiken lassen sich auf bekannte Sicherheitsgrundlagen zurückführen; daher sollten MCP-Server wie jede andere Integrationsoberfläche behandelt werden. Organisationen müssen Lieferkettenkontrollen anwenden, Code und Abhängigkeiten scannen, Versionen pinnen und Änderungen vor der Veröffentlichung überprüfen. Ebenso wichtig ist es, Endpunkte mit starker Authentifizierung und Autorisierung, Ratenbegrenzungen und sicheren Standardwerten zu härten. Diese Praktiken eliminieren einen großen Teil vermeidbarer Ausfälle.

Die MCP-Spezifikation bietet eine Liste von Sicherheitsbestepraktiken,mit häufigen Angriffs mustern und praktischen Minderungen, die Sie beim Aufbau oder Betrieb von MCP-Hosts, -Clients und -Servern anwenden können.

Wichtigste MCP-Sicherheitsrisiken

Um die Liste umsetzbar zu machen, hilft es, MCP-Bedrohungen in die häufigsten Risikomuster zu gruppieren, die Verteidiger in realen Implementierungen sehen.

Prompt Injection

Angreifer entwerfen Eingaben, die den Assistenten zu unsicherer Werkzeugnutzung oder sensibler Datenoffenlegung drängen.

Minderungstipp: Werkzeuginfrastruktur einschränken, Anrufrichtlinien durchsetzen und Werkzeugnutzung auf anormale Muster überwachen.

Indirekte Prompt Injection

Feindliche Anweisungen können durch abgerufene Inhalte eintreffen und als vertrauenswürdige Absicht behandelt werden.

Minderungstipp: Unzuverlässige Inhalte trennen, bereinigen und verhindern, dass Werkzeuge basierend auf in externen Daten gefundenen Anweisungen aufgerufen werden.

Werkzeugvergiftung

Werkzeugbeschreibungen, Parameter oder Standardeinstellungen können manipuliert werden, um Modellentscheidungen zu beeinflussen.

Minderungstipp: Behandeln Sie Werkzeugmetadaten als unvertrauenswürdige Eingabe, überprüfen Sie Werkzeugdefinitionen wie Code und erfordern Sie Integritätsprüfungen vor Updates.

Werkzeugverschattung und Werkzeugnamenskollision

Ähnlich aussehende Werkzeuge können legitime imitieren und Anfragen abfangen.

Minderungstipp: Eine Whitelist genehmigter Server und Werkzeuge führen und bei fehlender Verifizierung einer Werkzeugidentität geschlossen scheitern.

Autorisierungsfehler des verwirrten Stellvertreters

Ein Server führt Aktionen mit eigenen umfassenden Berechtigungen aus und nicht mit benutzergebundenen Berechtigungen.

Minderungstipp: Verwenden Sie explizite Zustimmung, setzen Sie benutzergebundene Geltungsbereiche durch und validieren Sie Tokens gemäß den MCP-Autorisierungsrichtlinien.

Token-Durchleitung und schwache Token-Validierung

Tokens weiterzuleiten oder ohne angemessene Adressvalidierung zu akzeptieren, untergräbt die Autorisierung.

Minderungstipp: Verbot der Durchleitung, Validierung der Token-Adresse und Befolgen des auf HTTP-Transporten basierenden OAuth-Fluss.

Sitzungshijacking

Angreifer missbrauchen wiederaufnehmbare Sitzungen oder gestohlene Kennungen, um Ereignisse zu injizieren oder einen Client zu imitieren.

Minderungstipp: Sitzungen eng binden, Kennungen rotieren, Zeitüberschreitungen anwenden und Wiederaufnahmen und Anomalien protokollieren.

Kompromiss des lokalen Servers

Lokale MCP-Server können genutzt werden, um auf Dateien zuzugreifen, Befehle auszuführen oder zu anderen Ressourcen zu wechseln, wenn sie nicht isoliert sind.

Minderungstipp: Lokale Server in einer Sandbox ausführen, OS-Berechtigungen minimieren, Dateisystemzugriff einschränken und lokale Dienste nur soweit wie nötig freigeben.

Übermäßige Geltungsbereiche und Genehmigungsaufblähung

Breite Geltungsbereiche schaffen unbeabsichtigten Zugang, und Berechtigungen neigen dazu, mit der Zeit anzuwachsen.

Minderungstipp: Lese- und Schreibwerkzeuge trennen, Geltungsbereiche regelmäßig überprüfen und Umfangssätze minimal und aufgabenbezogen halten.

Fehlende Auditierbarkeit und schwache Vorfallsreaktion

Wenn Sie keine Anfragen, Werkzeuginrufe, Tokens und Downstream-Aktionen korrelieren können, werden Untersuchungen zu einem Ratespiel.

Minderungstipp: Protokolle zentralisieren, Korrelations-IDs anhängen und Werkzeuginrufabsicht, Parameter und Ergebnisse in einem SIEM-freundlichen Format aufzeichnen.

Der praktische Rückschluss ist, dass MCP wie eine hochwirksame Integrationsschicht gesichert werden sollte. Gehen Sie davon aus, dass Werkzeugausgaben unzuverlässig sind, minimieren Sie Berechtigungen, setzen Sie starke Identität und Autorisierung durch und investieren Sie frühzeitig in ein Monitoring, das Anfragen mit Werkzeuginrufen und Downstream-Aktionen verknüpfen kann.

SOC Prime folgt etablierten Sicherheits- und Datenschutzpraktiken, um Kunden zu schützen und den vertrauenswürdigen Betrieb der SOC Prime-Plattform und der KI-fähigen Funktionen sicherzustellen. Das SOC Prime-Team hat auch AI/DR Bastionerstellt und als Open Source bereitgestellt, ein umfassendes GenAI-Schutzsystem, das gegen bösartige Aufforderungen, Injektionsangriffe und schädliche Inhalte schützt. Das System umfasst mehrere Erkennungsmaschinen, die sequentiell betrieben werden, um Benutzereingaben zu analysieren und zu klassifizieren, bevor sie GenAI-Anwendungen erreichen.

Darüber hinaus unterstützt die SOC Prime-Plattform die Integration mit AIDEFEND (Artificial Intelligence Defense Framework), einer offenen, AI-fokussierten Wissensbasis mit Abwehrmaßnahmen gegen aufkommende AI/ML-Bedrohungen. Unterstützt von Uncoder AI, dem AIDEFEND-native MCP macht dieses Wissen sofort anwendbar. Sicherheitsexperten können nach Verteidigungen gegen spezifische Bedrohungen fragen, detaillierte Technikleitfäden abrufen, schnelle Checklisten generieren oder sichere Code-Snippets extrahieren, um Kontrollen schneller und mit weniger Rechercheaufwand umzusetzen.

Was ist die Zukunft der MCP-Sicherheit?

Sicherheitsbedenken bezüglich MCP sind berechtigt, aber Standardisierung ist auch eine große Chance zur Verbesserung der Kontrolle. Da die MCP-Einführung wächst, erhalten Organisationen eine konsistentere Sicherheitsoberfläche, auf der sie dieselben Richtlinien und Überwachungen bei der Werkzeugnutzung anwenden können, anstatt eine andere kundenspezifische Integration für jedes Modell und jedes Downstream-System zu sichern.

Blick nach vorn wird sich die MCP-Sicherheit in einigen vorhersehbaren Richtungen entwickeln:

- Sichern Sie die MCP-Bausteine. Die MCP-Sicherheit wird sich zunehmend auf die Protokollprimitiven konzentrieren, die definieren, was ein Agent tun kann. Werkzeuge sind ausführbare Funktionen und benötigen enge Berechtigungen und klare Regeln für ihren Einsatz. Ressourcen fungieren als Datenspeicher und benötigen Zugriffskontrolle und Validierung, um Lecks und Manipulationen zu minimieren. Aufforderungen beeinflussen das Verhalten und müssen mit Lösungen wie AI/DR Bastion vor Injektion und unbefugter Modifikation geschützt werden.

- Machen Sie Identität für Remote-MCP obligatorisch. Für jeden im Netzwerk betriebenen MCP-Server sollte Authentifizierung als grundlegende Anforderung betrachtet werden. Teams benötigen ein klares Identitätsmodell, das beantwortet, wer den Anruf tätigt, was sie dürfen und welche Zustimmung erteilt wurde. Dies hilft auch, häufige Ausfälle zu verhindern, die im Spezifikation hervorgehoben werden, wie das Verhalten verwirrter Stellvertreter und gefährlicher Token-Handling-Muster.

- Erzwingen Sie Richtlinien mit vollständigem Kontext. Whitelist sind nützlich, aber Agenten-Workflows benötigen reichere Leitplanken. Der Prompt, der Benutzer, das ausgewählte Werkzeug, Werkzeugparameter und das Zielsystem sollten alle beeinflussen, was erlaubt ist. Mit diesem Kontext können Sie riskante Operationen einschränken, die Abfrage sensibler Daten begrenzen, unsichere Parameter-Patterns blockieren und zusätzliche Prüfungen verlangen, wenn das Risikoniveau hoch ist.

- Behandeln Sie Überwachung als Kernkontrolle. Da Agenten Aktionen verketten, hängt die Untersuchung davon ab, das Verhalten von Anfang bis Ende nachzuvollziehen. Eine praktische Grundlage ist eine Protokollierung, die Aufforderungen, Werkzeugauswahl, Werkzeugeingaben, Werkzeuga usgaben und nachgelagerte Anfragen korreliert. Ohne diese Verknüpfung ist es schwer, Aktionen zu auditieren oder schnell zu reagieren, wenn etwas schiefgeht.

- Fügen Sie Zustimmungs-Gates für hochwirksame Aktionen hinzu. Für Aktionen, die erstellen, ändern, löschen, zahlen oder Privilegien eskalieren, bleibt eine menschliche Überprüfung essenziell. Reife MCP-Bereitstellungen werden explizite Zustimmungsschritte hinzufügen, die die Ausführung pausieren, bis ein Benutzer oder ein Sicherheitsworkflow die Aktion bestätigt. Dies reduziert die Angriffsfläche sowohl durch bösartige Aufforderungen als auch versehentliches Werkzeugmissbrauch.

- Überprüfen Sie Server und kontrollieren Sie Updates. Mit der Ausweitung des Ökosystems werden Vertrauen und Herkunft obligatorisch. Organisationen werden vermehrt auf genehmigte MCP-Server, kontrolliertes Onboarding und striktes Änderungsmanagement für Updates setzen. Versionsbindung, Integritätsprüfungen und Abhängigkeitsprüfung sind wichtig, weil MCP-Server ausführbarer Code sind und sich das Werkzeugverhalten im Laufe der Zeit ändern kann, auch wenn die Schnittstellen stabil wirken.

-

Halten Sie die Grundlagen im Vordergrund. Selbst mit MCP-spezifischen Kontrollen bleiben die häufigsten Sicherheitspraktiken die Grundlagen. Minimalberechtigung, klare Geltungsbereiche, sichere Sitzungsverwaltung, starke Authentifizierung, gehärtete Endpunkte und vollständige Auditprotokollierung entfernen einen großen Anteil des realen Risikos. Nutzen Sie die MCP-Sicherheitspraktikenliste als ständige Checkliste und fügen Sie Kontrollen basierend auf Ihrer Umgebung und Ihrem Risikoprofil hinzu.

Da MCP zunehmend von Assistenten und Werkzeugen genutzt wird, wird Sicherheit zum Unterschied zwischen einem hilfreichen Kopiloten und einer unkontrollierten Automatisierungsmaschine. Der sicherste Weg ist einfach: Behandeln Sie MCP wie eine privilegierte Infrastruktur, halten Sie Berechtigungen eng und machen Sie jeden Werkzeuganruf sichtbar und nachvollziehbar. Machen Sie das gut, und MCP kann Agenten-Workflows mit Zuversicht skalieren, anstatt Geschwindigkeit in Risiko zu verwandeln.

FAQ

Was sind MCP-Server?

Der MCP-Server ist ein Baustein in der MCP-Architektur neben dem MCP-Host und dem MCP-Client. MCP-Server gewähren einem KI-Assistenten genehmigte Fähigkeiten, indem sie Werkzeuge und Ressourcen bereitstellen, die das LLM nutzen kann. MCP-Server stellen dem LLM den Kontext, Daten oder Aktionen bereit und vermitteln den Zugang zu nachgelagerten Systemen wie SaaS-Apps, Datenbanken, internen Diensten oder Sicherheitstools. Mit anderen Worten, ein MCP-Server ist das kontrollierte Gateway, über das Organisationen Autorisierungen, Datenfilterung und betriebliche Leitplanken anwenden können, bevor irgendetwas auf Produktionssysteme zugreift.

Wie funktionieren MCP-Server?

MCP-Server sitzen hinter dem MCP-Client innerhalb einer KI-Anwendung. Wenn ein Benutzer eine Anfrage stellt, entdeckt der MCP-Client, welche Werkzeuge von einem oder mehreren MCP-Servern verfügbar sind, und übermittelt relevanten Werkzeugkontext an das LLM. Das LLM entscheidet dann, was zu tun ist, und erstellt einen strukturierten Werkzeugaufruf mit Parametern. Der MCP-Client sendet diesen Werkzeugaufruf an den MCP-Server, der ihn gegen das nachgelagerte System ausführt und das Ergebnis in einem vorhersehbaren Format zurückgibt. Der Client leitet das Ergebnis an das LLM zurück, das entweder einen weiteren Werkzeugaufruf tätigt oder die endgültige Antwort an den Benutzer liefert.

Was ist der MCP-Sicherheitsfluss?

Der MCP-Sicherheitsfluss ist die Menge von Kontrollen, besten Praktiken und architektonischen Schritten, die erforderlich sind, um das Model Context Protocol sicher zu implementieren. Es beginnt mit starker Identität, Zustimmung und Minimalberechtigungsbereichen, sodass der MCP-Server im Namen des Benutzers handelt, statt breite Dienstberechtigungen zu nutzen. Dazu gehören sicherer Token-Handling und Sitzungsprotektoren, um das Risiko von Token-Durchleitung, Sitzungshijacking oder Ereignisinjektion zu reduzieren. Schließlich hängt es von der Durchsetzung und Sichtbarkeit ab, einschließlich Werkzeug-Whitelists, Eingabe- und Ausgabevalidierung, Isolation für lokale Server und zentralisierter Protokollierung, die Aufforderungen mit Werkzeug-Eingaben und Downstream-Aktionen für Untersuchungen und Vorfallsreaktionen verbindet.