Espera-se que as ameaças baseadas em IA cresçam exponencialmente. A principal fraqueza no lado do defensor não é mais ter boas ideias de detecção, mas transformar essas ideias em regras de produção rapidamente e em escala suficiente.

Malware Nativo de IA Superará SIEMs Tradicionais Sem Implantação Automatizada de Regras

Futuras famílias de malware provavelmente incorporarão pequenos LLMs ou modelos semelhantes diretamente no código. Isso possibilita comportamentos muito difíceis de lidar para as defesas tradicionais:

- Código auto-modificável que continua mudando para evitar assinaturas.

- Evasão consciente do contexto, onde o malware “observa” logs locais, processos em execução e ferramentas de segurança e adapta suas táticas em tempo real.

- “Agentes de ransomware de IA” autônomos que acessam plataformas externas para instruções, buscam novas cargas, negociam resgate e se redistribuem em uma forma diferente.

O malware começa a se comportar menos como um binário estático e mais como um serviço flexível que aprende e itera dentro de cada ambiente da vítima.

A maioria das configurações de SIEM não são projetadas para este mundo. Mesmo plataformas líderes geralmente suportam algumas centenas de regras no máximo. Isso não é suficiente para cobrir o volume e a variedade de técnicas impulsionadas por IA em grandes e complexos ambientes.

Aqui, o limite rígido é a capacidade do SOC. Cada regra tem um custo: ajuste, manuseio de falsos positivos, documentação e manutenção a longo prazo. E para manter a carga de trabalho sob controle, as equipes desativam ou, mais frequentemente, nunca embarcam uma parte significativa do potencial conteúdo de detecção.

Desligar uma regra que já está em monitoramento significa assumir explicitamente a responsabilidade de remover uma camada de defesa, então com capacidade limitada, muitas vezes parece mais seguro bloquear novas regras do que aposentar as existentes.

Por anos, a principal preocupação tem sido a fadiga de alertas – quando há muitos alertas para poucos analistas. Em um cenário de ameaças nativo de IA, outro problema se torna mais importante: lacunas de cobertura. O ataque mais perigoso é aquele que nunca aciona um alerta porque a regra necessária nunca foi escrita, aprovada ou implantada.

Isso muda o papel da liderança do SOC. O foco se move do microgerenciamento de regras individuais para o gerenciamento do portfólio de detecção como um todo:

- Quais comportamentos e ativos estão cobertos?

- Quais pontos cegos são aceitos, e por quê?

- Quão rápido o conjunto de regras pode mudar quando uma nova técnica, exploit ou campanha aparece?

Processos tradicionais tornam isso ainda mais difícil. QA manual, controle de mudanças lento e implantações baseadas em tickets podem estender o tempo de “sabemos como detectar isso” para “esta regra está ativa na produção” em dias ou semanas. Campanhas impulsionadas por IA podem se adaptar em poucas horas.

Para fechar essa lacuna, as operações SOC precisarão se tornar auxiliadas por IA:

- Geração de regras suportadas por IA e conversão de relatórios de ameaças, consultas de caçadores e pesquisa em regras prontas para implantação em várias linguagens de consulta.

- Mapeamento de cobertura automatizado contra estruturas como MITRE ATT&CK e contra telemetria real (fluxos, tópicos, índices, fontes de log) para ver o que está realmente sendo monitorado.

- Priorização inteligente de quais regras habilitar, silenciar ou ajustar com base no risco, criticidade para o negócio e impacto observado.

- Integração estreita com plataformas de eventos em tempo real, para que novas regras possam ser testadas, implementadas e revertidas com segurança em volumes muito grandes de dados.

Sem esse nível de automação e design centrado em streaming, o SIEM se torna um gargalo. Ameaças nativas de IA não esperarão por janelas de mudança semanais; a inteligência de detecção e a implantação de regras devem operar na velocidade do streaming.

Inteligência de Detecção Nativa de IA Se Tornará o Novo Padrão

Até 2026, fornecedores de cibersegurança serão julgados com base em quão profundamente a IA está incorporada em seu ciclo de vida de detecção, não se eles simplesmente “usam IA” como um rótulo de marketing. Compradores empresariais, especialmente na escala da Fortune 100, tratarão a inteligência de detecção nativa de IA como um requisito.

Concretamente, grandes clientes exigirão:

- LLMs privados, autogeridos, que não vazam telemetria ou lógica proprietária para nuvens públicas.

- Modelos eficientes em GPU otimizados especificamente para cargas de trabalho de inteligência de detecção, não para tarefas genéricas de chat ou conteúdo.

- Garantias claras de que os dados permanecem dentro de limites de confiança bem definidos.

Do lado do produto, a IA tocará todas as partes da pilha de detecção:

- Regras de detecção geradas por IA alinhadas com estruturas como MITRE ATT&CK (já em vigor no SOC Prime).

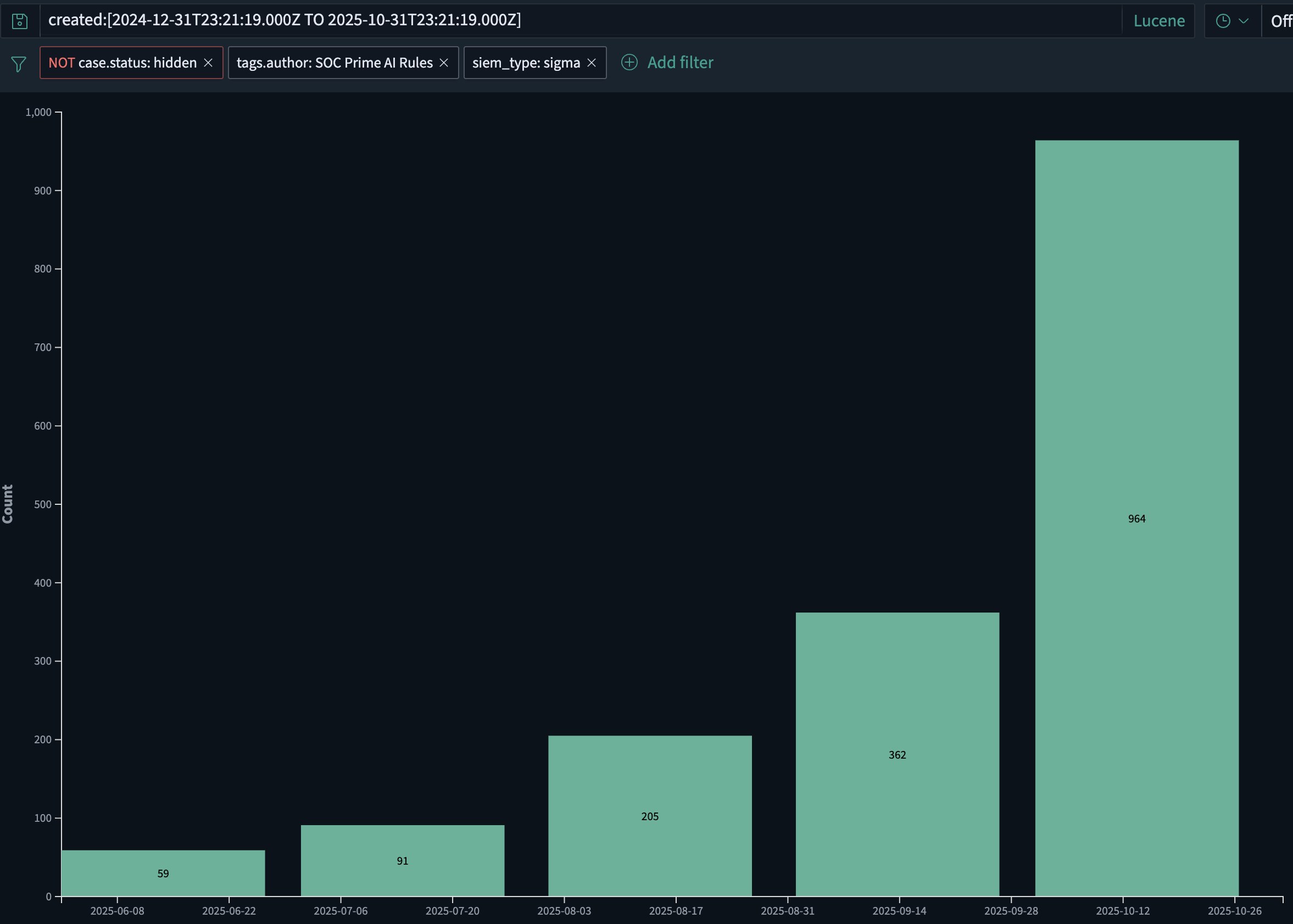

- Somente no SOC Prime, o volume de regras de detecção geradas por IA tem crescido aproximadamente 2x mês a mês, aumentando de cerca de 60 regras em junho de 2025 para quase 1.000 em outubro de 2025. Esse crescimento é impulsionado tanto pela implantação mais rápida de novas regras quanto pelo malware emergente alimentado por IA que requer IA para combater IA.

- Enriquecimento dirigido por IA, ajuste e adaptação de fonte de log para que as regras permaneçam relevantes à medida que a telemetria muda.

- Investigações retrospectivas assistidas por IA que podem reproduzir automaticamente uma nova lógica sobre dados históricos.

- Priorização baseada em IA de conteúdos de ameaça com base no stack do cliente, geografia, setor e perfil de risco.

Em outras palavras, a IA se torna parte da “fábrica” de detecção: como as regras são produzidas, mantidas e aposentadas em muitos ambientes. Até 2026, a inteligência de detecção suportada por IA não será mais uma funcionalidade de valor agregado; será a expectativa básica para plataformas de segurança sérias.

Provedores de Modelos de Fundação Possuirão uma Nova Camada de Segurança – e Precisarão de Firewalls LLM

À medida que grandes modelos de linguagem se tornam parte da infraestrutura central para desenvolvimento de software, operações e suporte, os provedores de modelos de fundação inevitavelmente se juntam à cadeia de responsabilidade em cibersegurança. Quando seus modelos são usados para gerar campanhas de phishing, malware ou código de exploração em grande escala, empurrar toda a responsabilidade para as organizações usuárias finais não é mais realista.

Espera-se que os provedores de modelos de fundação detectem e limitem casos de uso claramente maliciosos e controlem como suas APIs são usadas, enquanto ainda permitem testes e pesquisas de segurança legítimos. Isso inclui:

- Triagem de prompts para sinais óbvios de intenção maliciosa, como instruções passo a passo para obter acesso inicial, escalar privilégios, mover-se lateralmente ou exfiltrar dados.

- Monitoramento de padrões de uso suspeitos entre inquilinos, como loops automatizados, comportamento semelhante a infraestrutura ou geração repetida de conteúdo de segurança ofensivo.

- Aplicação de respostas graduadas: limitação de taxa, verificação extra, revisão humana ou bloqueio rígido quando o abuso é óbvio.

Filtros genéricos de “não ajude com hacking” não são suficientes. Uma camada de segurança dedicada para o tráfego LLM é necessária – um firewall LLM.

Um firewall LLM fica entre aplicativos e o modelo e foca no risco cibernético:

- Ele realiza a inspeção semântica de prompts e saídas para indicadores de planejamento e execução de ataques.

- Ele aplica políticas: o que é permitido, o que deve ser mascarado ou transformado e o que deve ser bloqueado totalmente.

- Ele produz telemetria de segurança que pode ser alimentada em SIEM, SOAR e análises de streaming para investigação e correlação com outros sinais.

Produtos como AI DR Bastion são projetados com esse papel em mente: uma camada protetora ao redor do uso de LLM que se especializa em detectar e interromper o uso cibernético ofensivo.

Este tipo de controle pode ajudar:

- Empresas que consomem LLMs, reduzindo o risco de que usuários internos ou aplicativos possam facilmente armar modelos.

- Provedores de modelos e plataformas, dando-lhes um mecanismo concreto para mostrar que estão controlando ativamente o abuso de suas APIs.

À medida que os LLMs são incorporados em pipelines de CI/CD, assistentes de desenvolvedor, fluxos de atendimento ao cliente, ferramentas de resposta a incidentes e até mesmo no próprio malware, a fronteira entre “segurança de IA” e “segurança de aplicações” desaparece. Provedores de modelos, equipes de plataformas e organizações de segurança compartilharão a responsabilidade por como esses sistemas são usados.

Nesta arquitetura, os firewalls LLM se tornam uma camada padrão, semelhante a como os WAFs e gateways de API são padrão hoje – trabalhando ao lado de SIEM e análises de streaming em tempo real para garantir que as mesmas capacidades de IA que aceleram os resultados de negócios não se tornem um multiplicador de força para atacantes.

A Era da “Detecção Antecipada” Começará

Até 2026, muitos programas de segurança empresarial reconhecerão que enviar toda a telemetria para um SIEM primeiro, e só então executar a detecção, é tanto financeiramente insustentável quanto operacionalmente muito lento.

A próxima geração de pilha moverá a lógica de detecção mais perto de onde os dados são produzidos e transportados:

- Diretamente em brokers de eventos, pipelines ETL e plataformas de streaming como Confluent Kafka.

- Como parte do tecido de dados, não apenas no final do pipeline.

O resultado é um modelo de “detecção antecipada”:

- Mais da metade das grandes empresas devem começar a avaliar ou testar arquiteturas onde a detecção em tempo real é executada na camada de streaming.

- O SIEM evolui para uma camada de conformidade, investigação e retenção, enquanto a lógica de detecção de primeira linha é executada em dados em movimento.

- Regras de detecção de alto desempenho, neutras de fornecedor, que podem ser executadas em escala de streaming se tornam um diferenciador chave.

Neste modelo, o conteúdo de detecção de ameaças não está mais vinculado a um único mecanismo de SIEM. Regras e análises precisam ser:

- Expressas em formatos que podem ser executados em plataformas de streaming e em vários backends.

- Geridas como um catálogo compartilhado que pode ser impulsionado “antes do SIEM” e ainda assim rastreado, auditado e ajustado ao longo do tempo.

A direção do produto do SOC Prime para 2026 está alinhada com essa mudança: construindo um pipeline em linha de velocidade que roda antes do SIEM e integra diretamente com plataformas de streaming. Isso torna possível combinar:

- Inteligência de detecção nativa de IA em escala,

- Execução em tempo real em fluxos de eventos, e

- Correlação, retenção e conformidade downstream em SIEM e plataformas de dados.

Tomados em conjunto, malware nativo de IA, abuso de LLM, inteligência de detecção impulsionada por IA e arquiteturas de detecção antecipada definem a próxima onda de ameaças cibernéticas – e a forma das defesas necessárias para enfrentá-las.