Si prevede che le minacce basate sull’IA crescano esponenzialmente. La principale debolezza dal lato del difensore non è più formulare buone idee di rilevamento, ma trasformare rapidamente tali idee in regole di produzione in misura sufficiente e su vasta scala.

Il Malware Nativo AI Supererà gli SIEM Tradizionali Senza Distribuzione Automatica delle Regole

Le future famiglie di malware probabilmente incorporeranno piccoli LLM o modelli simili direttamente nel loro codice. Questo abilita un comportamento che le difese tradizionali gestiscono con molta difficoltà:

- Codici auto-modificanti che continuano a cambiare per evitare le firme.

- Evasione consapevole del contesto, dove il malware “osserva” i log locali, i processi in esecuzione e gli strumenti di sicurezza e adatta le sue tattiche in tempo reale.

- Agenti “ransomware AI autonomi” che chiamano piattaforme esterne per istruzioni, recuperano nuovi payload, negoziano il riscatto e poi si ridistribuiscono in una forma diversa.

Il malware inizia a comportarsi meno come un binario statico e più come un servizio flessibile che apprende e si adatta all’interno di ogni ambiente vittima.

La maggior parte delle configurazioni SIEM non sono progettate per questo mondo. Anche le piattaforme principali di solito supportano al massimo alcune centinaia di regole. Questo non è sufficiente a coprire il volume e la varietà di tecniche guidate dall’IA attraverso grandi ed estese strutture complesse. In pratica, una copertura seria significa migliaia di regole attive mappate a fonti di log specifiche, risorse e casi d’uso.

Qui, il limite difficile è la capacità del SOC. Ogni regola ha un costo: configurazione, gestione dei falsi positivi, documentazione e manutenzione a lungo termine. E per mantenere il carico di lavoro sotto controllo, i team disabilitano o, più spesso, non implementano mai una parte significativa del potenziale contenuto di rilevamento.

Spegnere una regola già in monitoraggio significa prendersi esplicitamente la responsabilità di rimuovere un livello di difesa, quindi con una capacità limitata, spesso sembra più sicuro bloccare nuove regole piuttosto che ritirare quelle esistenti.

Per anni, la principale preoccupazione è stata la fatica da allerta – quando ci sono troppi avvisi per troppo pochi analisti. In un panorama di minacce nativo dell’IA, un altro problema diventa più importante: le lacune di copertura. L’attacco più pericoloso è quello che non genera mai un avviso perché la regola richiesta non è mai stata scritta, mai approvata o mai distribuita.

Ciò sposta il ruolo della leadership SOC. L’attenzione si sposta dal microgestire regole individuali alla gestione del portafoglio di rilevamento complessivo:

- Quali comportamenti e risorse sono coperti?

- Quali punti ciechi sono accettati, e perché?

- Quanto velocemente può cambiare il set di regole quando appare una nuova tecnica, exploit o campagna?

I processi tradizionali rendono tutto ciò ancora più difficile. Controllo qualità manuale, controllo delle modifiche lento e implementazioni guidate da ticket possono estendere i tempi da “sappiamo come rilevare questo” a “questa regola è attiva in produzione” in giorni o settimane. Le campagne guidate dall’IA possono adattarsi in poche ore.

Per colmare questa lacuna, le operazioni SOC devono diventare a loro volta AI-assistite:

- Generazione e conversione delle regole supportata dall’IA dai report sulle minacce, query di hunting e ricerche in regole pronte per essere distribuite in più linguaggi di interrogazione.

- Mappatura automatizzata della copertura contro framework come MITRE ATT&CK e contro la telemetria reale (flussi, argomenti, indici, fonti di log) per vedere cosa viene effettivamente monitorato.

- Prioritizzazione intelligente di quali regole abilitare, silenziare o regolare in base al rischio, alla criticità aziendale e all’impatto osservato.

- Integrazione stretta con piattaforme di streaming eventi in tempo reale, in modo che nuove regole possano essere testate, distribuite e ritirate in sicurezza su grandi volumi di dati.

Senza questo livello di automazione e un design orientato allo streaming, SIEM diventa un collo di bottiglia. Le minacce native dell’IA non aspetteranno finestre di modifica settimanali; l’intelligenza di rilevamento e la distribuzione delle regole devono operare alla velocità dello streaming.

L’Intelligenza di Rilevamento Nativa AI Diventerà il Nuovo Standard

Entro il 2026, i fornitori di cybersecurity saranno valutati su quanto profondamente l’IA è incorporata nel loro ciclo di vita del rilevamento, non sul fatto che semplicemente “usino l’IA” come etichetta di marketing. Gli acquirenti aziendali, specialmente su scala Fortune 100, tratteranno l’intelligenza di rilevamento nativa dell’IA come un requisito.

Concretamente, i grandi clienti richiederanno:

- LLM autogestiti e privati che non perdano telemetria o logiche proprietarie sui cloud pubblici.

- Modelli efficienti per GPU ottimizzati specificamente per carichi di lavoro di intelligenza di rilevamento, non per compiti generici di chat o contenuti.

- Garanzie chiare che i dati rimangano entro confini di fiducia ben definiti.

Dal punto di vista del prodotto, l’IA toccherà ogni parte dello stack di rilevamento:

- Regole di rilevamento generate dall’IA allineate a framework come MITRE ATT&CK (già in atto presso SOC Prime).

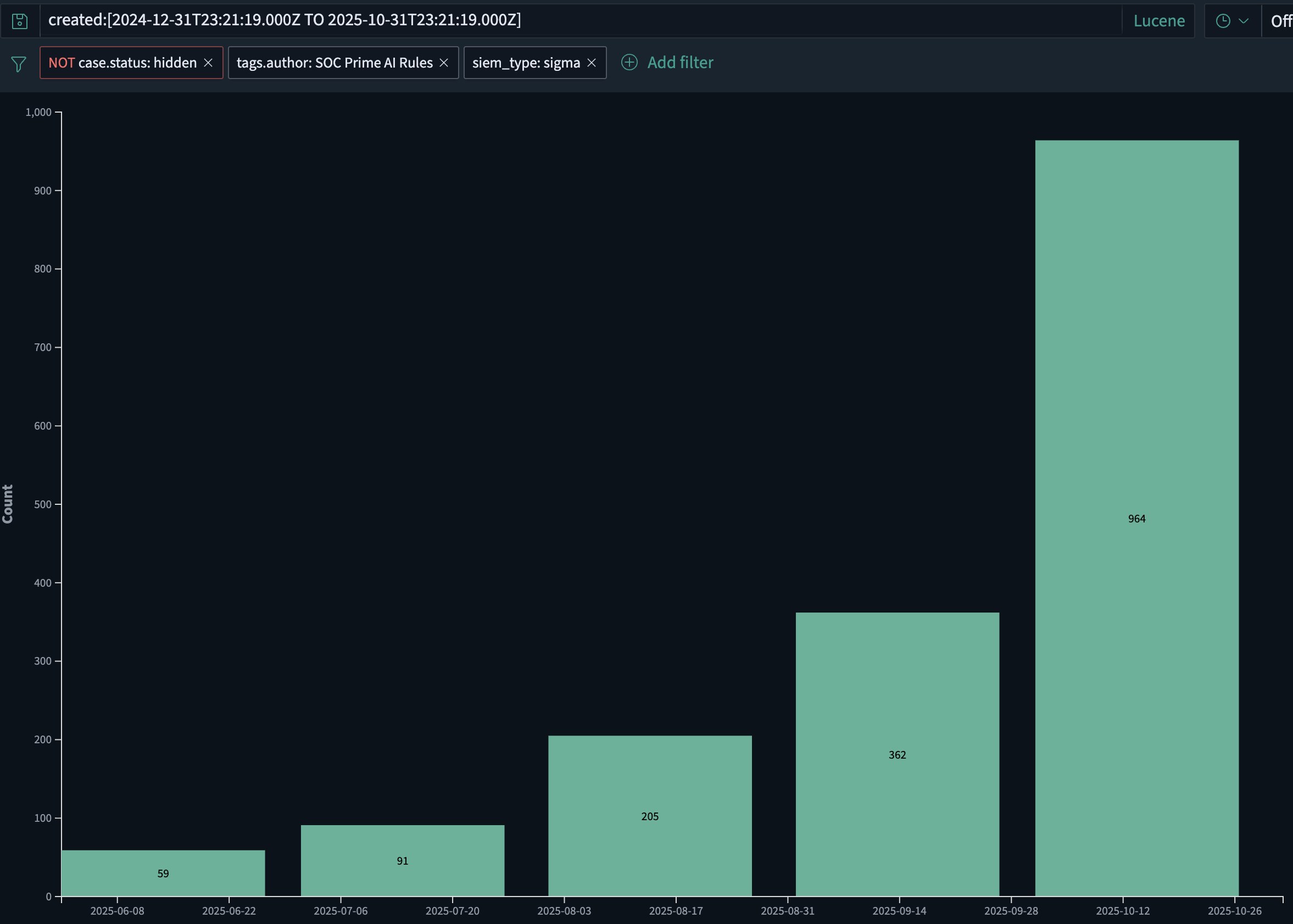

- Solo in SOC Prime, il volume di regole di rilevamento generate dall’IA è cresciuto di circa il 2x mese dopo mese, aumentando da circa 60 regole a giugno 2025 a quasi 1.000 a ottobre 2025. Questa crescita è guidata sia dalla distribuzione più veloce di nuove regole che dall’emergere di malware guidati dall’IA che richiedono l’IA per combattere l’IA.

- Arricchimento, regolazione e adattamento alle fonti di log guidati dall’IA in modo che le regole rimangano rilevanti mentre la telemetria cambia.

- Indagini retrospettive assistite dall’IA in grado di rigiocare automaticamente la nuova logica su dati storici.

- Prioritizzazione guidata dall’IA dei contenuti sulle minacce in base allo stack del cliente, geografia, settore e profilo di rischio.

In altre parole, l’IA diventa parte della “fabbrica” del rilevamento: come le regole sono prodotte, mantenute e ritirate in molti ambienti. Entro il 2026, l’intelligenza di rilevamento supportata dall’IA non sarà più una caratteristica aggiuntiva; sarà l’aspettativa di base per le piattaforme di sicurezza serie.

I Fornitori di Modelli Fondamentali Domineranno un Nuovo Livello di Sicurezza – e Avranno Bisogno di Firewall LLM

Man mano che i grandi modelli linguistici diventano parte dell’infrastruttura core per lo sviluppo software, operazioni e supporto, i fornitori di modelli fondamentali inevitabilmente entrano a far parte della catena di responsabilità della cybersecurity. Quando i loro modelli vengono utilizzati per generare campagne di phishing, malware o codice di exploit su larga scala, spingere tutta la responsabilità alle organizzazioni utilizzatrici finali non è più realistico.

Ci si aspetterà che i fornitori di modelli fondamentali rilevino e limitino chiaramente gli usi malintenzionati e controllino come vengono utilizzate le loro API, pur consentendo test di sicurezza legittimi e ricerche. Questo include:

- Analizzare i prompt per segni evidenti di intenti malevoli, come istruzioni passo-passo per ottenere accessi iniziali, aumentare i privilegi, muoversi lateralmente o esfiltrare dati.

- Osservare modelli d’uso sospetti tra i tenant come cicli automatici, comportamenti simili a infrastrutture, o generazione ripetuta di contenuti di sicurezza offensivi.

- Applicare risposte graduate: limitazione del tasso, verifiche extra, revisione umana o blocco totale quando l’abuso è evidente.

I filtri generici “non aiutare con l’hacking” non sono sufficienti. È necessario uno strato di sicurezza dedicato per il traffico LLM – un firewall LLM.

Un firewall LLM si posiziona tra le applicazioni e il modello e si concentra sul rischio cibernetico:

- Esegue l’ispezione semantica dei prompt e degli output per individuare indicatori di pianificazione ed esecuzione di attacchi.

- Imporre politiche: cosa è consentito, cosa deve essere mascherato o trasformato e cosa deve essere bloccato completamente.

- Genera telemetria di sicurezza che può essere trasmessa in SIEM, SOAR e analisi di streaming per investigazione e correlazione con altri segnali.

Prodotti come AI DR Bastion sono progettati con questo ruolo in mente: uno strato protettivo attorno all’uso di LLM che si specializza nel rilevare e fermare l’uso cibernetico offensivo.

Questo tipo di controllo può aiutare:

- Le aziende che consumano LLM, riducendo il rischio che utenti o applicazioni interni possano facilmente armare i modelli.

- Fornitori di modelli e piattaforme, fornendo loro un meccanismo concreto per dimostrare che stanno attivamente controllando l’abuso delle loro API.

Man mano che gli LLM vengono integrati nei pipeline CI/CD, assistenti per sviluppatori, flussi di supporto clienti, strumenti di risposta agli incidenti e persino malware stesso, il confine tra “sicurezza AI” e “sicurezza delle applicazioni” scompare. I fornitori di modelli, i team di piattaforma e le organizzazioni di sicurezza condivideranno la responsabilità di come questi sistemi vengono utilizzati.

In questa architettura, i firewall LLM diventano uno strato standard, simile a come WAF e API gateway sono standard oggi – lavorando insieme a SIEM e analisi di streaming in tempo reale per garantire che le stesse capacità AI che accelerano i risultati aziendali non diventino un moltiplicatore di forza per gli attaccanti.

L’Era della “Rilevazione Spostata a Sinistra” Inizierà

Entro il 2026, molti programmi di sicurezza aziendali riconosceranno che spingere tutta la telemetria in un SIEM prima e solo successivamente eseguire il rilevamento, è sia finanziariamente insostenibile che operativamente troppo lento.

La prossima generazione di stack sposterà la logica di rilevamento più vicino a dove vengono prodotti e trasportati i dati:

- Direttamente nei broker di eventi, nelle pipeline ETL e nelle piattaforme di streaming come Confluent Kafka.

- Come parte del tessuto dati, non solo alla fine della pipeline.

Il risultato è un modello di “rilevamento spostato a sinistra”:

- Si prevede che oltre la metà delle grandi imprese inizi a valutare o sperimentare architetture dove il rilevamento in tempo reale viene eseguito nel livello di streaming.

- Il SIEM evolve verso uno strato di conformità, indagine e conservazione, mentre la logica di rilevamento di prima linea viene eseguita sui dati in movimento.

- Regole di rilevamento ad alte prestazioni e neutrali rispetto al fornitore che possono essere eseguite su scala di streaming diventano differenziatori chiave.

In questo modello, il contenuto di rilevamento delle minacce non è più legato a un singolo motore SIEM. Le regole e le analisi devono essere:

- Espresse in formati che possono essere eseguiti su piattaforme di streaming e in più backend.

- Gestite come un catalogo condiviso che può essere spinto “prima del SIEM” e ancora tracciato, auditato e regolato nel tempo.

La direzione del prodotto di SOC Prime per il 2026 è allineata a questo cambiamento: costruendo un pipeline a velocità di linea che funziona prima del SIEM ed è integrata direttamente con le piattaforme di streaming. Questo rende possibile combinare:

- Intelligenza di rilevamento nativa AI su larga scala,

- Esecuzione in tempo reale su flussi di eventi, e

- Correlazione, conservazione e conformità a valle in SIEM e piattaforme dati.

Presi insieme, malware nativo dell’IA, abuso di LLM, intelligenza di rilevamento guidata dall’IA e architetture di rilevamento spostate a sinistra definiscono la prossima ondata di minacce informatiche – e la conformazione delle difese necessarie per affrontarle.