On s’attend à ce que les menaces basées sur l’IA croissent de manière exponentielle. La principale faiblesse du côté des défenseurs n’est plus de concevoir de bonnes idées de détection, mais de transformer ces idées en règles de production assez rapidement et à une échelle suffisante.

Les logiciels malveillants natifs à l’IA dépasseront les SIEM traditionnels sans déploiement automatisé des règles

Les futures familles de malwares intégreront probablement de petits LLM ou des modèles similaires directement dans leur code. Cela permet un comportement très difficile à gérer pour les défenses traditionnelles :

- Code auto-modifiant qui change constamment pour éviter les signatures.

- Évasion contextuelle, où le malware « regarde » les journaux locaux, les processus en cours et les outils de sécurité et adapte ses tactiques à la volée.

- Agents de ransomware autonomes « IA » qui sollicitent des plateformes externes pour obtenir des instructions, récupérer de nouvelles charges utiles, négocier des rançons, puis se redéployer sous une forme différente.

Les logiciels malveillants commencent à se comporter moins comme un binaire statique et davantage comme un service flexible qui apprend et itère dans chaque environnement victime.

La plupart des configurations de SIEM ne sont pas conçues pour ce monde. Même les plateformes leaders supportent généralement quelques centaines de règles au maximum. Cela ne suffit pas à couvrir le volume et la variété des techniques guidées par l’IA à travers des environnements grands et complexes. En pratique, une couverture sérieuse signifie des milliers de règles actives mappées à des sources de journaux spécifiques, des actifs et des cas d’utilisation.

Ici, la limite difficile est la capacité du SOC. Chaque règle a un coût : ajustement, gestion des faux positifs, documentation, et maintenance à long terme. Et pour garder la charge de travail sous contrôle, les équipes désactivent ou, plus souvent, n’embarquent jamais une partie significative du contenu de détection potentiel.

Désactiver une règle déjà en surveillance signifie assumer explicitement la responsabilité de supprimer une couche de défense, donc avec une capacité limitée, il semble souvent plus sûr de bloquer de nouvelles règles que de retirer les existantes.

Depuis des années, la principale préoccupation a été la fatigue des alertes – lorsqu’il y a trop d’alertes pour trop peu d’analystes. Dans un paysage de menaces natif à l’IA, un autre problème devient plus important : les lacunes de couverture. L’attaque la plus dangereuse est celle qui ne déclenche jamais d’alerte parce que la règle requise n’a jamais été écrite, approuvée ou déployée.

Cela déplace le rôle de la direction du SOC. L’accent est mis sur la gestion du portefeuille de détection global :

- Quels comportements et actifs sont couverts ?

- Quelles zones d’ombre sont acceptées, et pourquoi ?

- À quelle vitesse le jeu de règles peut-il évoluer lorsqu’une nouvelle technique, un exploit ou une campagne apparaît ?

Les processus traditionnels rendent cela encore plus difficile. Le contrôle de qualité manuel, le contrôle des changements lent et les déploiements basés sur les tickets peuvent étirer le temps de « nous savons comment détecter cela » à « cette règle est opérationnelle » jusqu’à des jours ou des semaines. Les campagnes dirigées par l’IA peuvent s’adapter en quelques heures.

Pour combler cet écart, les opérations SOC devront elles-mêmes devenir assistées par l’IA :

- Génération et conversion de règles soutenues par l’IA à partir de rapports de menaces, de requêtes de chasse et de recherches en règles prêtes à déployer dans plusieurs langages de requêtes.

- Cartographie automatisée de la couverture contre des cadres comme MITRE ATT&CK et contre une télémétrie réelle (flux, sujets, indices, sources de journaux) pour voir ce qui est effectivement surveillé.

- Priorisation intelligente des règles à activer, à mettre sous silence ou à affiner en fonction du risque, de la criticité pour l’entreprise et de l’impact observé.

- Intégration étroite avec les plateformes de streaming d’événements en temps réel, pour que les nouvelles règles puissent être testées, déployées et annulées en toute sécurité à travers de très grands volumes de données.

Sans ce niveau d’automatisation et de conception tournée vers le streaming, le SIEM devient un goulot d’étranglement. Les menaces natives à l’IA n’attendront pas les fenêtres de changement hebdomadaires ; l’intelligence de détection et le déploiement des règles doivent fonctionner à la vitesse du streaming.

L’intelligence de détection native à l’IA deviendra la nouvelle norme

D’ici 2026, les fournisseurs de cybersécurité seront jugés sur la profondeur de l’intégration de l’IA dans leur cycle de vie de détection, et non sur le fait qu’ils « utilisent l’IA » comme argument marketing. Les acheteurs d’entreprises, en particulier à l’échelle Fortune 100, traiteront l’intelligence de détection native à l’IA comme une exigence.

Concrètement, les grands clients exigeront :

- LLM privés et auto-gérés qui ne divulguent pas de télémétrie ou de logique propriétaires aux clouds publics.

- Modèles efficaces en termes de GPU optimisés spécifiquement pour les charges de travail d’intelligence de détection, et non pour les tâches génériques de chat ou de contenu.

- Garantie claire que les données restent dans des limites de confiance bien définies.

Du côté du produit, l’IA touchera chaque partie de la pile de détection :

- Règles de détection générées par l’IA alignées sur des cadres comme MITRE ATT&CK (déjà en place chez SOC Prime).

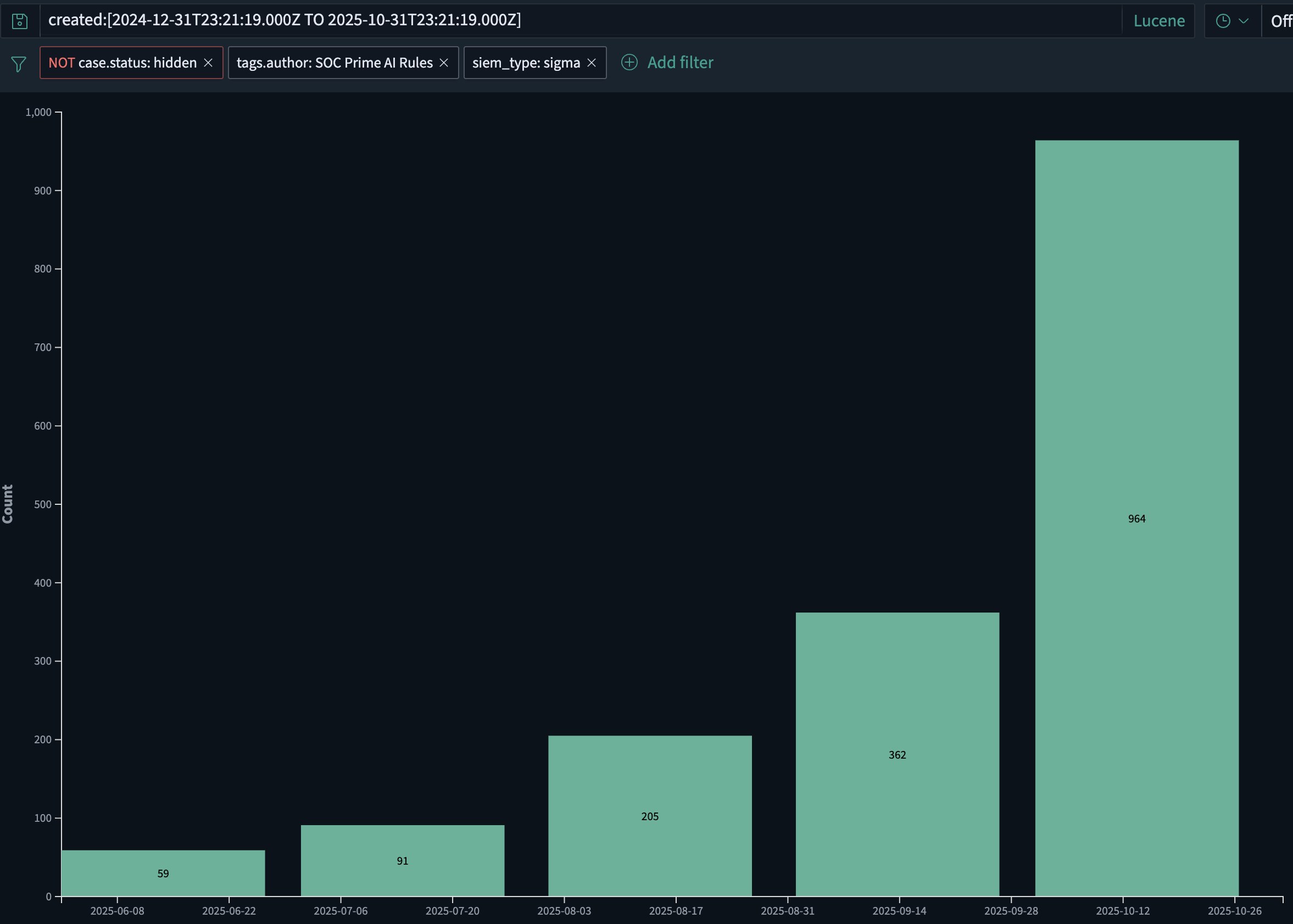

- Chez SOC Prime seulement, le volume de règles de détection générées par l’IA a augmenté d’environ 2x mois après mois, passant d’environ 60 règles en juin 2025 à près de 1 000 en octobre 2025. Cette croissance est alimentée à la fois par le déploiement plus rapide de nouvelles règles et par l’émergence de malwares alimentés par l’IA nécessitant l’utilisation de l’IA pour lutter contre l’IA.

- Enrichissement, ajustement et adaptation des sources de journaux pilotés par l’IA pour que les règles restent pertinentes à mesure que la télémétrie évolue.

- Investigations rétrospectives assistées par l’IA pouvant rejouer automatiquement de nouvelles logiques sur des données historiques.

- Priorisation basée sur l’IA du contenu de menace en fonction de la pile client, de la géographie, du secteur et du profil de risque.

En d’autres termes, l’IA fait partie de la « fabrique de détection » : comment les règles sont produites, maintenues et retirées à travers de nombreux environnements. D’ici 2026, l’intelligence de détection soutenue par l’IA ne sera plus une fonctionnalité à valeur ajoutée ; elle sera l’attente de base pour les plateformes de sécurité sérieuses.

Les fournisseurs de modèles de fondation posséderont une nouvelle couche de sécurité – et auront besoin de pare-feu LLM

Alors que les grands modèles de langage deviennent partie intégrante de l’infrastructure de développement de logiciels, d’opérations et de support, les fournisseurs de modèles de fondation rejoignent inévitablement la chaîne de responsabilité en cybersécurité. Lorsque leurs modèles sont utilisés pour générer des campagnes de phishing, des logiciels malveillants ou du code d’exploitation à grande échelle, transférer toute la responsabilité aux organisations utilisatrices n’est plus réaliste.

Les fournisseurs de modèles de fondation devront détecter et limiter les cas d’utilisation clairement malveillants et contrôler comment leurs API sont utilisées, tout en permettant des tests de sécurité et des recherches légitimes. Cela inclut :

- Filtrer les invites pour déceler les signes évidents d’intention malveillante, comme des instructions étape par étape pour obtenir un accès initial, escalader des privilèges, se déplacer latéralement ou exfiltrer des données.

- Surveiller les modèles d’utilisation suspects à travers les locataires, tels que les boucles automatisées, les comportements d’infrastructure ou la génération répétée de contenu de sécurité offensif.

- Appliquer des réponses graduées : limitation de débit, vérification supplémentaire, revue humaine ou blocage sévère lorsque l’abus est évident.

Les filtres génériques « ne pas aider au hacking » ne suffisent pas. Une couche de sécurité dédiée pour le trafic LLM est nécessaire – un pare-feu LLM.

Un pare-feu LLM se situe entre les applications et le modèle et se concentre sur le risque cyber :

- Il effectue une inspection sémantique des invites et des sorties pour détecter les indicateurs de planification et d’exécution d’attaques.

- Il applique la politique : ce qui est autorisé, ce qui doit être masqué ou transformé, et ce qui doit être entièrement bloqué.

- Il génère une télémétrie de sécurité pouvant être intégrée dans le SIEM, le SOAR et les analyses de streaming pour une enquête et une corrélation avec d’autres signaux.

Des produits comme AI DR Bastion sont conçus avec ce rôle à l’esprit : une couche protectrice autour de l’utilisation des LLM spécialisée dans la détection et l’arrêt des utilisations cyber offensives.

Ce type de contrôle peut aider :

- Les entreprises qui consomment des LLM, en réduisant le risque que les utilisateurs internes ou les applications puissent facilement armer les modèles.

- Les fournisseurs de modèles et de plateformes, en leur donnant un mécanisme concret pour montrer qu’ils contrôlent activement l’abus de leurs API.

Alors que les LLM sont intégrés dans les pipelines CI/CD, les assistants des développeurs, les flux de support client, les outils de réponse aux incidents et même dans les logiciels malveillants eux-mêmes, la frontière entre « sécurité IA » et « sécurité des applications » disparaît. Les fournisseurs de modèles, les équipes de plateformes et les organisations de sécurité partageront la responsabilité de la manière dont ces systèmes sont utilisés.

Dans cette architecture, les pare-feu LLM deviennent une couche standard, similaire à la manière dont les WAF et les passerelles API sont standard aujourd’hui – travaillant aux côtés du SIEM et des analyses de streaming en temps réel pour garantir que les mêmes capacités IA qui accélèrent les résultats commerciaux ne deviennent pas un multiplicateur de force pour les attaquants.

L’ère de la « détection shift-left » va commencer

D’ici 2026, de nombreux programmes de sécurité d’entreprise reconnaîtront que pousser toute la télémétrie dans un SIEM d’abord, puis seulement exécuter la détection, est à la fois financièrement insoutenable et opérationnellement trop lent.

La pile de nouvelle génération déplacera la logique de détection plus près de là où les données sont produites et transportées :

- Directement dans les courtiers d’événements, les pipelines ETL et les plateformes de streaming telles que Confluent Kafka.

- Comme partie de la trame de données, et non seulement à la fin du pipeline.

Le résultat est un modèle de « détection shift-left » :

- Plus de la moitié des grandes entreprises devraient commencer à évaluer ou piloter des architectures où la détection en temps réel fonctionne dans la couche de streaming.

- Le SIEM évolue vers une couche de conformité, d’enquête et de rétention, tandis que la logique de détection en première ligne s’exécute sur les données en mouvement.

- Les règles de détection performantes et neutres du vendeur, pouvant fonctionner à l’échelle du streaming, deviennent un facteur clé de différenciation.

Dans ce modèle, le contenu de détection des menaces n’est plus lié à un seul moteur de SIEM. Les règles et analyses doivent être :

- Exprimées dans des formats pouvant s’exécuter sur des plateformes de streaming et dans plusieurs backends.

- Gérées en tant que catalogue partagé pouvant être poussé « avant le SIEM » et encore tracé, audité et ajusté au fil du temps.

La direction des produits de SOC Prime pour 2026 est alignée avec ce changement : construire un pipeline à la vitesse de la ligne qui fonctionne avant le SIEM et s’intègre directement avec les plateformes de streaming. Cela permet de combiner :

- Intelligence de détection native à l’IA à grande échelle,

- Exécution en temps réel sur des flux d’événements, et

- Corrélation, rétention et conformité en aval dans le SIEM et les plateformes de données.

Pris ensemble, les logiciels malveillants natifs à l’IA, l’abus de LLM, l’intelligence de détection guidée par l’IA, et les architectures de détection shift-left définissent la prochaine vague de menaces cyber – et la forme des défenses nécessaires pour y faire face.