AIマルウェアとLLM悪用: サイバー脅威の次なる波

目次:

AIベースの脅威は指数的に成長すると予想されています。守る側の主な弱点はもはや良い検出アイデアを考え出すことではなく、それらのアイデアを素早くそして十分な規模で製品化することです。

AIネイティブのマルウェアは、SIEMを自動ルールデプロイメントなしで凌駕する

将来のマルウェアファミリーは、小さなLLMや類似のモデルをコードに直接組み込む可能性があります。これにより、従来の防御では対処が非常に難しい振る舞いが可能になります:

- 署名を回避するために自己修正し続けるコード。

- コンテキスト認識の回避策として、マルウェアがローカルのログ、実行中のプロセス、セキュリティツールを「見て」その場で戦術を適応させる。

- 外部プラットフォームに指示を求め、新しいペイロードを取得し、身代金を交渉した後、別の形式で再展開する自律型「AIランサムウェアエージェント」。

マルウェアは静的なバイナリというよりも、各被害者の環境内で学習し反復する柔軟なサービスのように振る舞い始めます。

ほとんどのSIEMセットアップはこの新しい世界には設計されていません。大手プラットフォームでさえ、通常は数百のルールを最大でサポートしています。これは、大規模で複雑な環境でAI駆動の技術の量と多様性をカバーするには十分ではありません。実際には、深刻なカバレッジには、特定のログソース、資産、ユースケースにマッピングされた数千のアクティブルールが必要です。

ここでのハードリミットはSOCの容量です。すべてのルールにはコストがかかります:チューニング、偽陽性の処理、文書化、長期的なメンテナンス。そして、作業負荷を制御するために、チームは潜在的な検出コンテンツの重要な部分を無効にするか、より頻繁には導入しません。

既に監視中のルールをオフにするということは、防御の一層を除去する責任を明示的に取ることを意味します。したがって、容量が限られている場合、新しいルールをブロックするのが既存のものを廃止するよりも安全に感じます。

長年にわたり、主な懸念はアラート疲れでした。つまり、アナリストが少ないのにアラートが多すぎる状態です。AIネイティブな脅威環境では、より重要になる別の問題が浮かび上がります:カバレッジのギャップです。最も危険な攻撃は、必要なルールが書かれていない、承認されていない、または配備されていないため、アラートをトリガーしない攻撃です。

これにより、SOCリーダーシップの役割が変わります。フォーカスは個別のルールを細かく管理することから、全体的な検出ポートフォリオを管理することへの移行です:

- どの行動と資産がカバーされていますか?

- どの盲点が受け入れられていて、その理由は?

- 新しい技術、エクスプロイト、キャンペーンが現れたとき、ルールセットはどれくらい速く変化できるか?

従来のプロセスではこれをさらに難しくします。手動のQA、遅い変更管理、チケット駆動のデプロイにより、「これを検出する方法を知っている」という状態から「このルールが本番で可動中である」という状態までの時間が、日や週にわたって伸びる可能性があります。AI駆動のキャンペーンは数時間で適応できます。

このギャップを埋めるために、SOC運用自体がAI支援される必要があります:

- 脅威レポート、ハンティングクエリ、調査を準備済みのルールに変換し、複数のクエリ言語にわたってデプロイするためのAIサポートのルール生成と変換。

- MITRE ATT&CKなどのフレームワークおよび実際のテレメトリ(ストリーム、トピック、インデックス、ログソース)に対する自動カバレッジマッピングで、何が実際に監視されているかを確認します。

- リスク、ビジネスの重要性、観察された影響に基づいて有効化する、静音化する、または調整するルールのインテリジェントな優先順位付け。

- リアルタイムイベントストリーミングプラットフォームとの緊密な統合により、新しいルールをテスト、展開、ロールバックを安全に大規模なデータにわたって行うことができます。

このレベルの自動化とストリーミングファーストの設計がなければ、SIEMはボトルネックになります。AIネイティブの脅威は週次の変更ウィンドウを待たず、検出の知性とルールの展開はストリーミング速度で動作する必要があります。

AIネイティブ検出インテリジェンスが新しい標準になる

2026年までに、サイバーセキュリティベンダーは、検出ライフサイクルにどれだけ深くAIが組み込まれているかで評価されるようになります。単に「AIを使っている」といったマーケティングラベルではありません。特にフォーチュン100規模のエンタープライズバイヤーは、AIネイティブ検出インテリジェンスを要件とします。

具体的に、大規模顧客は以下を要求するでしょう:

- プロプライエタリなテレメトリやロジックをパブリッククラウドに漏らさないセルフマネージドのプライベートLLM。

- 一般的なチャットやコンテンツタスクではなく、検出インテリジェンスのワークロードに特化して最適化されたGPU効率の高いモデル。

- データが明確に定義された信頼の境界内で留まるという明確な保証。

製品側では、AIが検出スタックのあらゆる部分に触れることになるでしょう:

- MITRE ATT&CKのようなフレームワークに整合したAI生成の検出ルール(SOC Primeでも既に実施中)。

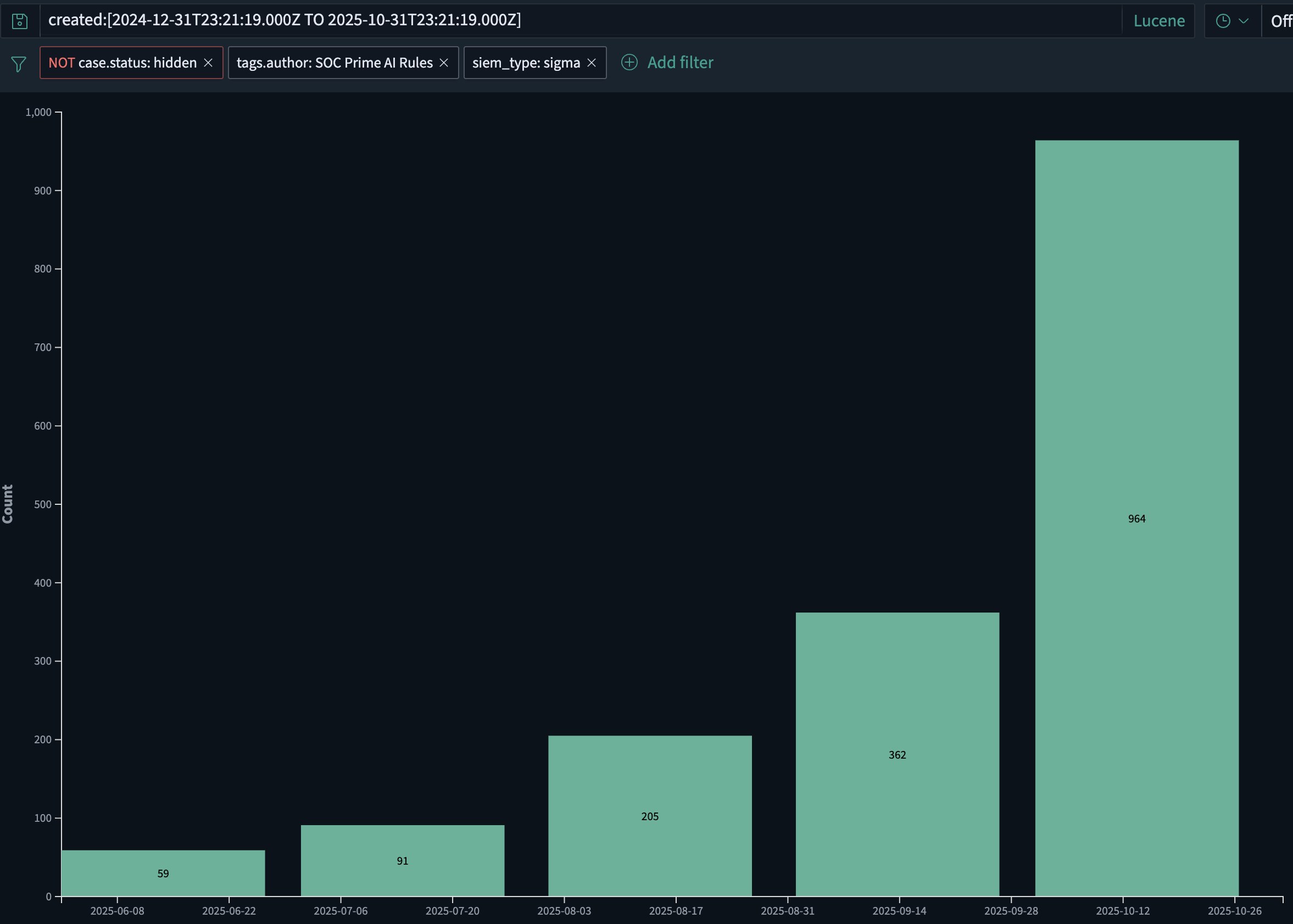

- SOC Primeだけでも、AI生成の検出ルールの量は、月ごとに約2倍のペースで増加し、2025年6月に約60ルールから2025年10月には約1,000に増加しています。この成長は、新しいルールのより速い展開と、AIを駆使してAIと対抗する必要のある新たに出現するAIパワードマルウェアによって促進されています。

- AI駆動の強化、チューニング、ログソースの適応により、テレメトリの変化に応じてルールが関連性を保つ。

- 過去のデータに新しい論理を自動で適用できるAI支援の遡及調査。

- 顧客のスタック、地理、セクター、およびリスクプロファイルに基づく脅威コンテンツのAIベースの優先順位付け。

つまり、AIは検出の「工場」の一部となります:ルールがどのように生成され、維持され、様々な環境で廃止されるか。2026年までには、AI支援の検出インテリジェンスはもはや付加価値機能ではなく、真剣なセキュリティプラットフォームに対する基準値期待になります。

ファウンデーションモデルプロバイダーは新しいセキュリティレイヤーを所有することになり、LLMファイアウォールが必要になります

大規模言語モデルがソフトウェアの開発、運用、サポートのコアインフラストラクチャの一部になるにつれて、ファウンデーションモデルプロバイダーは避けられずにサイバーセキュリティの責任チェーンに加わります。彼らのモデルがフィッシングキャンペーン、マルウェア、またはエクスプロイトコードを大規模に生成するとき、全責任をエンドユーザー組織に押し付けることはもはや現実的ではありません。

ファウンデーションモデルプロバイダーは、明らかに悪意のある使用ケースを検出し制限することを期待され、APIが使用される方法を制御しながら、正当なセキュリティテストと研究を許可する必要があります。これには以下が含まれます:

- 初期アクセスを得るための段階的な指示、権限の昇格、横移動、データの抽出などの悪意ある意図の明確な兆候を示すプロンプトをスクリーニングする。

- テナント間での自動化されたループ、インフラストラクチャのような挙動、攻撃的なセキュリティコンテンツの繰り返し生成などの疑わしい使用パターンを監視する。

- 段階的な対策を適用する:明白な乱用があるとき、レートリミッティング、追加の確認、人によるレビュー、または強力なブロック。

一般的な「ハッキングを手伝わないで」フィルターでは不十分です。LLMトラフィック専用のセキュリティレイヤー、つまりLLMファイアウォールが必要です。

LLMファイアウォールはアプリケーションとモデルの間に位置し、サイバーリスクに焦点を当てています:

- 攻撃計画や実行のインジケータのためにプロンプトとアウトプットを意味論的に検査します。

- ポリシーを実施します:何が許可されているか、何がマスクまたは変換されるべきか、完全にブロックされるべきか。

- SIEM、SOAR、ストリーミング分析に取り込めるセキュリティテレメトリを生成し、他の信号と対照して調査と相関付けを可能にします。

製品は AI DRバスティオン この役割を念頭に置いて設計されています:LLMの使用を保護し、攻撃的なサイバー使用を検出し停止することに特化した保護層。

この種の制御は次のことを支援できます:

- 内部ユーザーやアプリケーションがモデルを簡単に武器化するリスクを軽減することでLLMを消費する企業を。

- APIの悪用を積極的に管理していることを示す具体的なメカニズムを提供することで、モデルおよびプラットフォームプロバイダーを。

LLMがCI/CDパイプライン、開発者アシスタント、カスタマーサポートフロー、インシデント対応ツール、さらにはマルウェア自体に組み込まれている場合、「AIセキュリティ」と「アプリケーションセキュリティ」の境界は消えます。モデルプロバイダー、プラットフォームチーム、およびセキュリティ組織は、これらのシステムがどのように使用されるかについての責任を共有します。

このアーキテクチャでは、LLMファイアウォールは標準レイヤーとなり、今日のWAFやAPIゲートウェイと同様に標準になります。SIEMおよびリアルタイムストリーミング分析と共に機能し、ビジネス成果を加速するのと同じAI機能が攻撃者の倍増装置にならないことを保証します。

「Shift-Left Detection」の時代が始まる

2026年までには、多くの企業のセキュリティプログラムが、すべてのテレメトリを先にSIEMに送り込み、それから検出を行うことが、財政的に持続不可能であり、運用スピードも遅すぎることに気づくでしょう。

次世代スタックは、データが生成され、輸送される場所に検出ロジックをもっと近づけます:

- 直接イベントブローカー、ETLパイプライン、ストリーミングプラットフォーム、例えば Confluent Kafka.

- データファブリックの一部として、パイプラインの終わりだけでなく。

その結果生じるのは「Shift-Left Detection」モデルです:

- 大型企業の過半数が、リアルタイム検出がストリーミングレイヤーで実行されるアーキテクチャの評価または試験を始めることが予想されます。

- SIEMはコンプライアンス、調査、保持レイヤーへと進化し、第一線の検出ロジックは移動中のデータに対して実行されます。

- ストリーミングスケールで実行可能なベンダーニュートラルで高性能な検出ルールが鍵となる差別化要因になります。

このモデルでは、脅威検出コンテンツはもはや単一のSIEMエンジンに縛られません。ルールと分析は以下を必要とします:

- ストリーミングプラットフォームおよび複数のバックエンドで実行できるフォーマットで表現されること。

- 「SIEM前」に押し出すことができ、時間をかけて追跡、監査、チューニングが可能な共有カタログとして管理されること。

SOC Primeの2026年の製品方針はこの変化と一致しています: ラインスピードパイプライン を構築し、SIEM前で動作し、ストリーミングプラットフォームに直接統合します。これにより、以下の組み合わせが可能になります:

- スケールにおけるAIネイティブ検出インテリジェンス、

- イベントストリームのリアルタイム実行、および

- SIEMおよびデータプラットフォームでの下流の相関、保持、コンプライアンス。

AIネイティブマルウェア、LLMの悪用、AI駆動の検出インテリジェンス、Shift-Left Detectionアーキテクチャがサイバー脅威の次の波を定義し、それに対抗するために必要な防御の形態を決定します。