Malware de IA y Abuso de LLM: La Próxima Ola de Amenazas Cibernéticas

Tabla de contenidos:

Se espera que las amenazas basadas en IA crezcan exponencialmente. La principal debilidad del lado del defensor ya no es idear buenas ideas de detección, sino convertir esas ideas en reglas de producción lo suficientemente rápido y a una escala suficiente.

El malware nativo de IA superará a los SIEM tradicionales sin la implementación automatizada de reglas

Es probable que las futuras familias de malware inserten pequeños LLM o modelos similares directamente en su código. Esto habilita un comportamiento que es muy difícil de manejar para las defensas tradicionales:

- Código auto-modificante que sigue cambiando para evitar firmas.

- Evasión consciente del contexto, donde el malware «observa» registros locales, procesos en ejecución y herramientas de seguridad y adapta sus tácticas sobre la marcha.

- Agentes autónomos de «ransomware de IA» que llaman a plataformas externas para instrucciones, buscan nuevas cargas, negocian el rescate y luego se redeployan en una forma diferente.

El malware comienza a comportarse menos como un binario estático y más como un servicio flexible que aprende y se adapta dentro de cada entorno víctima.

La mayoría de configuraciones SIEM no están diseñadas para este mundo. Incluso las plataformas líderes suelen admitir unas pocas cientos de reglas como máximo. Eso no es suficiente para cubrir el volumen y la variedad de técnicas impulsadas por IA en propiedades grandes y complejas. En la práctica, una cobertura seria significa miles de reglas activas mapeadas a fuentes de registro específicas, activos y casos de uso.

Aquí, el límite difícil es la capacidad del SOC. Cada regla tiene un costo: ajuste, manejo de falsos positivos, documentación y mantenimiento a largo plazo. Y para mantener la carga de trabajo bajo control, los equipos desactivan o, más a menudo, nunca incorporan una parte significativa del contenido potencial de detección.

Apagar una regla que ya está en monitoreo significa tomar explícitamente la responsabilidad de eliminar una capa de defensa, por lo que con una capacidad limitada, a menudo parece más seguro bloquear nuevas reglas que retirar las existentes.

Durante años, la principal preocupación ha sido la fatiga de alertas, cuando hay demasiadas alertas para muy pocos analistas. En un paisaje de amenazas nativo de IA, otro problema se vuelve más importante: las brechas de cobertura. El ataque más peligroso es el que nunca desencadena una alerta porque la regla requerida nunca fue escrita, nunca fue aprobada o nunca fue desplegada.

Esto desplaza el rol del liderazgo del SOC. El enfoque pasa de la microgestión de reglas individuales a la gestión del portafolio de detección general:

- ¿Qué comportamientos y activos están cubiertos?

- ¿Qué puntos ciegos se aceptan y por qué?

- ¿Qué tan rápido puede cambiar el conjunto de reglas cuando aparece una nueva técnica, explotación o campaña?

Los procesos tradicionales hacen esto aún más difícil. La QA manual, el control de cambios lento y las implementaciones impulsadas por tickets pueden extender el tiempo desde «sabemos cómo detectar esto» hasta «esta regla está en producción» a días o semanas. Las campañas impulsadas por IA pueden adaptarse en cuestión de horas.

Para cerrar esta brecha, las operaciones SOC tendrán que volverse asistidas por IA:

- Generación de reglas asistida por IA y conversión de informes de amenazas, consultas de caza e investigación en reglas listas para implementar en múltiples lenguajes de consulta.

- Mapeo de cobertura automatizado contra marcos como MITRE ATT&CK y contra telemetría real (flujos, temas, índices, fuentes de registros) para ver lo que realmente se monitorea.

- Priorización inteligente de qué reglas habilitar, silenciar o ajustar según el riesgo, la criticidad del negocio y el impacto observado.

- Integración estrecha con plataformas de transmisión de eventos en tiempo real, para que las nuevas reglas puedan ser probadas, desplegadas y retiradas de manera segura en grandes volúmenes de datos.

Sin este nivel de automatización y diseño centrado en la transmisión, el SIEM se convierte en un cuello de botella. Las amenazas nativas de IA no esperarán ventanas de cambio semanales; la inteligencia de detección y la implementación de reglas deben operar a la velocidad de transmisión.

La inteligencia de detección nativa de IA se convertirá en el nuevo estándar

Para 2026, los proveedores de ciberseguridad serán juzgados por cuán profundamente está integrada la IA en su ciclo de vida de detección, no por si simplemente «usan IA» como etiqueta de marketing. Los compradores empresariales, especialmente a nivel Fortune 100, tratarán la inteligencia de detección nativa de IA como un requisito.

Concretamente, los grandes clientes demandarán:

- LLM privados autogestionados que no filtren telemetría o lógica propietaria a las nubes públicas.

- Modelos eficientes en GPU optimizados específicamente para cargas de trabajo de inteligencia de detección, no para tareas genéricas de chat o contenido.

- Garantías claras de que los datos permanecen dentro de límites de confianza bien definidos.

En el lado del producto, la IA tocará cada parte de la pila de detección:

- Reglas de detección generadas por IA alineadas con marcos como MITRE ATT&CK (ya en uso en SOC Prime).

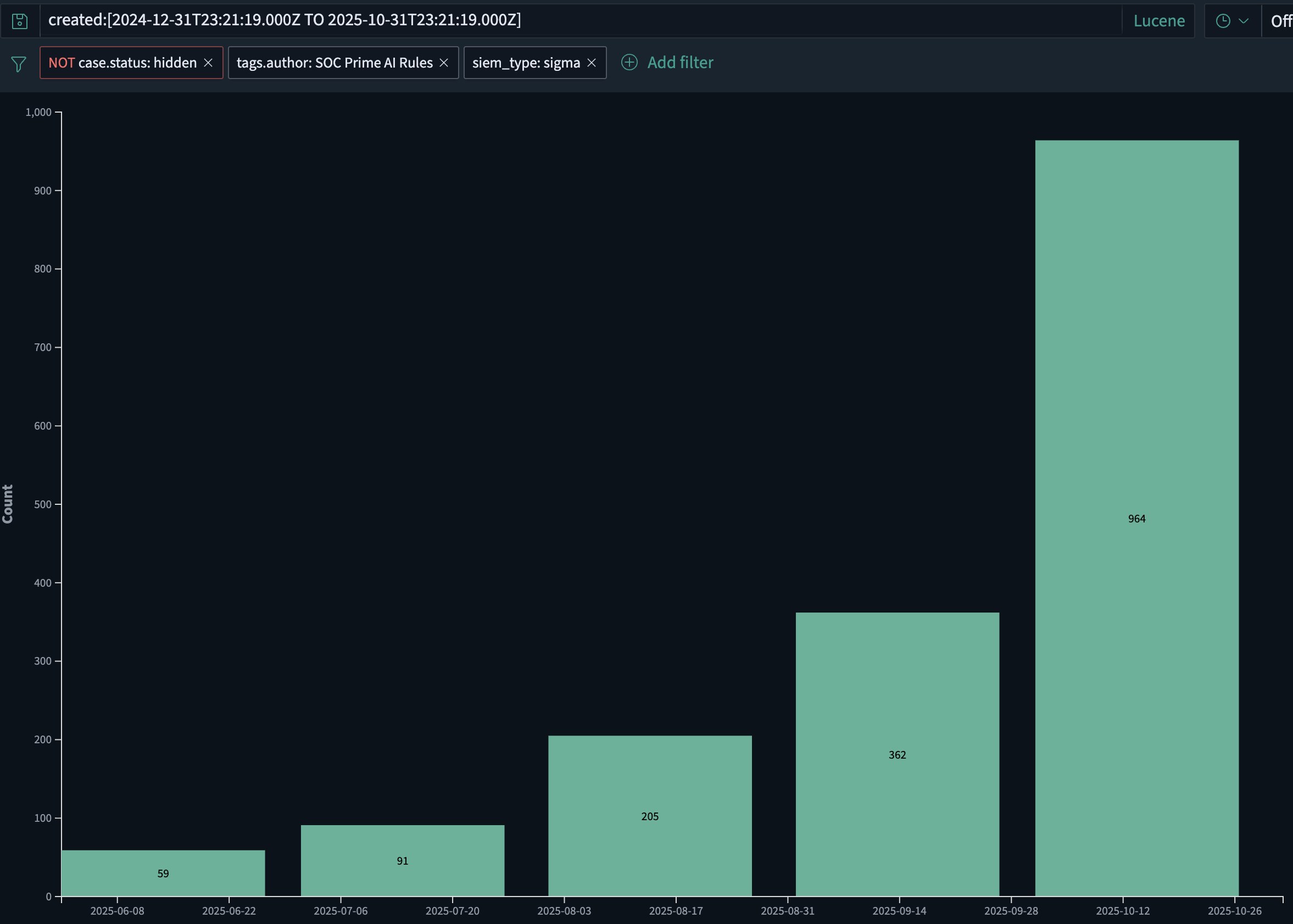

- En SOC Prime solamente, el volumen de reglas de detección generadas por IA ha estado creciendo aproximadamente 2x mes a mes, pasando de unas 60 reglas en junio de 2025 a casi 1,000 en octubre de 2025. Este crecimiento es impulsado tanto por la implementación más rápida de nuevas reglas como por el malware emergente impulsado por IA que requiere IA para combatir IA.

- Enriquecimiento, ajuste y adaptación de fuentes de registro impulsados por IA para que las reglas sigan siendo relevantes a medida que cambia la telemetría.

- Investigaciones retrospectivas asistidas por IA que pueden reproducir automáticamente la nueva lógica sobre datos históricos.

- Priorización basada en IA de contenido de amenazas basada en la pila del cliente, la geografía, el sector y el perfil de riesgo.

En otras palabras, la IA se convierte en parte de la «fábrica» de detección: cómo se producen, mantienen y retiran las reglas en muchos entornos. Para 2026, la inteligencia de detección asistida por IA ya no será una característica adicional de valor; será la expectativa básica para las plataformas de seguridad serias.

Los proveedores de modelos base poseerán una nueva capa de seguridad y necesitarán firewalls para LLM

A medida que los grandes modelos de lenguaje se convierten en parte de la infraestructura central para el desarrollo de software, operaciones y soporte, los proveedores de modelos base inevitablemente se unen a la cadena de responsabilidad de ciberseguridad. Cuando sus modelos se utilizan para generar campañas de phishing, malware o código de explotación a gran escala, empujar toda la responsabilidad a las organizaciones de usuarios finales ya no es realista.

Se espera que los proveedores de modelos base detecten y limiten claramente los casos de uso malicioso y controlen cómo se utilizan sus APIs, al tiempo que permiten pruebas de seguridad legítimas e investigación. Esto incluye:

- Examinar indicaciones de obvios signos de intención maliciosa, como instrucciones paso a paso para obtener acceso inicial, escalar privilegios, moverse lateralmente o exfiltrar datos.

- Monitorear patrones de uso sospechosos entre inquilinos como bucles automatizados, comportamiento parecido a infraestructuras o generación repetida de contenido de seguridad ofensivo.

- Aplicar respuestas graduadas: limitación de tasa, verificación adicional, revisión humana o bloqueos estrictos cuando el abuso es obvio.

Los filtros genéricos de «no ayudar con el hacking» no son suficientes. Se necesita una capa de seguridad dedicada para el tráfico de LLM: un firewall LLM.

Un firewall LLM se sitúa entre las aplicaciones y el modelo y se centra en el riesgo cibernético:

- Realiza una inspección semántica de indicaciones y salidas para indicadores de planificación y ejecución de ataques.

- Impone políticas: qué está permitido, qué debe ser enmascarado o transformado, y qué debe ser completamente bloqueado.

- Produce telemetría de seguridad que puede ser alimentada en SIEM, SOAR y análisis de transmisión para investigación y correlación con otras señales.

Productos como AI DR Bastion están diseñados con este papel en mente: una capa protectora alrededor del uso de LLM que se especializa en detectar y detener el uso cibernético ofensivo.

Este tipo de control puede ayudar a:

- Empresas que consumen LLMs, reduciendo el riesgo de que usuarios internos o aplicaciones puedan armamentar modelos fácilmente.

- Proveedores de modelos y plataformas, al brindarles un mecanismo concreto para demostrar que están controlando activamente el abuso de sus APIs.

A medida que los LLMs se integran en pipelines de CI/CD, asistentes de desarrollo, flujos de soporte al cliente, herramientas de respuesta a incidentes e incluso en el mismo malware, la frontera entre «seguridad de IA» y «seguridad de aplicaciones» desaparece. Los proveedores de modelos, equipos de plataforma y organizaciones de seguridad compartirán la responsabilidad de cómo se utilizan estos sistemas.

En esta arquitectura, los firewalls LLM se convierten en una capa estándar, similar a cómo los WAFs y las puertas de enlace API son estándar hoy en día, trabajando junto con SIEM y el análisis de transmisión en tiempo real para garantizar que las mismas capacidades de IA que aceleran los resultados comerciales no se conviertan en un multiplicador de fuerza para los atacantes.

Comenzará la era de la «detección de Desplazamiento a la Izquierda»

Para 2026, muchos programas de seguridad empresarial reconocerán que empujar toda la telemetría a un SIEM primero, y solo entonces ejecutar la detección, es a la vez financieramente insostenible y operativamente demasiado lento.

La pila de próxima generación moverá la lógica de detección más cerca de donde se produce y transporta la data:

- Directamente en brokers de eventos, pipelines ETL y plataformas de transmisión como Confluent Kafka.

- Como parte del tejido de datos, no solo al final del pipeline.

El resultado es un modelo de «detección de Desplazamiento a la Izquierda»:

- Se espera que más de la mitad de las grandes empresas comiencen a evaluar o pilotar arquitecturas donde la detección en tiempo real se ejecuta en la capa de transmisión.

- El SIEM evoluciona hacia una capa de cumplimiento, investigación y retención, mientras que la lógica de detección de primera línea se ejecuta en los datos en movimiento.

- Las reglas de detección de alto rendimiento y neutrales al proveedor que pueden funcionar a escala de transmisión se convierten en un diferenciador clave.

En este modelo, el contenido de detección de amenazas ya no está vinculado a un solo motor SIEM. Las reglas y los análisis necesitan ser:

- Expresados en formatos que pueden ejecutarse en plataformas de transmisión y en múltiples backend.

- Gestionados como un catálogo compartido que puede ser impulsado «antes del SIEM» y aún trazado, auditado y ajustado con el tiempo.

La dirección del producto de SOC Prime para 2026 está alineada con este cambio: construyendo una tubería de velocidad de línea que se ejecuta antes del SIEM e integra directamente con plataformas de transmisión. Esto hace posible combinar:

- Inteligencia de detección nativa de IA a escala,

- Ejecución en tiempo real en flujos de eventos, y

- Correlación, retención y cumplimiento posteriores en plataformas SIEM y de datos.

En conjunto, el malware nativo de IA, el abuso de LLM, la inteligencia de detección impulsada por AI y las arquitecturas de detección de Desplazamiento a la Izquierda definen la próxima ola de amenazas cibernéticas y la forma de las defensas necesarias para enfrentarlas.